La maîtrise statistique des processus

Les grandes écoles, depuis de nombreuses années, forment les futurs ingénieurs et cadres aux méthodes statistiques. Bien que tout le monde n’ait pas l’occasion de les pratiquer, chacun sait qu’elles aident à résoudre de nombreux problèmes techniques dans la recherche et dans l’industrie. En revanche, les décideurs ignorent souvent qu’elles permettent de réduire facilement les marges d’incertitude qui s’attachent aux prévisions, notamment dans le commerce, la finance et l’administration. C’est pourquoi nous allons présenter ici des méthodes destinées particulièrement aux prévisions et aux décisions.

Ce ne sont pas des idées nouvelles : elles sont utilisées depuis cinquante ans sous le titre » MSP » (Maîtrise statistique des processus) ou en anglais » SPC » (Statistical Process Control)1. Mais comme elles sont connues presque uniquement des ingénieurs qui travaillent dans le domaine de la qualité, on a tendance à croire qu’elles ne s’appliquent pas dans les autres domaines, ce qui est manifestement faux. Nous verrons par ailleurs qu’elles ne peuvent donner de bons résultats que si elles s’accompagnent d’un certain état d’esprit nommé » sens des variations « 2.

Il est utile, pour commencer, de situer la MSP dans l’ensemble des méthodes statistiques. Distinguons tout d’abord deux grandes catégories d’études statistiques : les études énumératives, ayant pour but de décrire les caractéristiques d’une population finie, et les études analytiques, ayant pour but d’améliorer un processus. Les études démographiques, par exemple, appartiennent à la première catégorie ; les études de mise au point d’un produit dans un laboratoire appartiennent à la seconde. Nous ne nous attarderons pas sur la statistique énumérative, si importante qu’elle soit, car notre problème se rattache entièrement à la statistique analytique ; mais remarquons dès maintenant que la notion de population, essentielle dans une étude énumérative, est mineure dans une étude analytique, où les notions de système et de processus sont prédominantes. Cette différence est rarement signalée dans les cours de statistiques ; nous y reviendrons.

La statistique analytique

La statistique analytique est née à l’aube du XXe siècle lorsque Karl Pearson, professeur de mathématiques au London University College, inventa une méthode de test permettant de vérifier si un ensemble de données numériques se rattache à un modèle mathématique déterminé (souvent, en pratique, c’est la distribution normale). Les idées de Pearson se sont imposées rapidement. Bien que d’autres modes de calcul statistique soient utilisés aujourd’hui, grâce à l’informatique, les ingénieurs ont presque tous entendu parler du test du » khi-deux « . Cette invention considérable a ouvert la voie aux méthodes modernes de prévision et de jugement sur échantillon, que l’on pourrait définir en quelques mots par la présence d’un intervalle de variation autour de la moyenne.

Henri Poincaré a fait remarquer en 1902 que les sciences naturelles, depuis des temps très anciens, avaient tendance à éliminer les variations aléatoires des résultats d’une expérience. Cette tendance simplificatrice n’était pas le fait du hasard, mais une option philosophique. L’idée était pertinente, car c’est en négligeant délibérément dans leurs observations une multitude de petites variations que les savants ont pu imaginer des théories qui ont fait progresser la connaissance de la nature. Encore aujourd’hui, il n’est pas un élève ingénieur qui n’ait été amené un jour, en séance de travaux pratiques, à tracer une courbe passant entre des points disposés irrégulièrement. Mais le fait de prendre en considération les variations aléatoires avec de nouveaux outils mathématiques (analyse linéaire) a permis à la science du XXe siècle de faire un grand bond en avant. C’est effectivement de cette manière, par exemple, que s’est élaborée la mécanique quantique.

À la même époque, William Gossett, un collègue de Karl Pearson qui écrivait sous le pseudonyme de Student, inventa une méthode statistique consistant à comparer des mesures faites sur deux échantillons prélevés dans des lots d’origines différentes, afin de faire un choix économique. Cette méthode fut appliquée aussitôt avec succès dans les brasseries Guiness pour améliorer la qualité du produit.

La théorie de Student fut la première utilisation de la variance dans un problème de comparaison d’échantillons. Certains l’opposent à la loi des grands nombres, parce que les calculs de Student n’utilisent ordinairement qu’un petit nombre de données ; mais en y regardant de plus près on voit bien que c’est un faux débat, car cette loi s’applique à un autre type de problème.

Cette loi est simplement la traduction du théorème de Bernoulli suivant lequel la fréquence des résultats de tirages indépendants dans une population binomiale converge en probabilité vers la proportion qui caractérise cette population. Or dans le problème traité par Student, il n’existe pas de population, mais un processus qui produit des données. La différence est encore plus évidente dès que l’on a compris que la loi des grands nombres concerne les études énumératives tandis que la théorie de Student concerne les études analytiques.

L’analyse de variance

La théorie de Student fut généralisée au bout de quelques années sous le titre d’analyse de variance, afin d’étudier simultanément plus de deux échantillons et plusieurs facteurs de variation concernant un même processus. Vers 1920, Ronald Fisher inventa la méthode dite des plans d’expérience. Ingénieur agronome, Fisher avait commencé à travailler au centre de recherches de Rothamsted, une ferme expérimentale de la région de Londres. Les chercheurs de cet établissement voulaient trouver les meilleures méthodes pour cultiver des légumes et des céréales.

Si les expériences avaient été faites dans des serres, en vérifiant soigneusement la température, l’humidité et la composition du sol, les conclusions n’auraient pas été applicables à des cultures faites dans des conditions normales. C’est pourquoi Fisher a décidé d’étudier ce qui se passait en plein champ. Le problème était de réaliser des expériences dans des conditions fixées par la nature, c’est-à-dire difficiles à contrôler. Fisher a montré comment s’y prendre, en utilisant les variances, et ses idées ont été adoptées dans le monde entier, notamment aux États-Unis.

Les scientifiques n’ont pas compris tout de suite que l’œuvre de Fisher marquait un tournant décisif dans l’histoire des sciences, et que ses idées ne se limitaient pas à l’agriculture. Il a montré pour la première fois comment la démarche expérimentale pouvait sortir du laboratoire. Ses méthodes ont entraîné des progrès considérables en médecine et en biologie ; à partir de 1960, grâce à Taguchi, elles ont eu des effets spectaculaires dans l’industrie japonaise.

Après ce rapide survol de la principale branche de la statistique descriptive3, nous allons présenter la théorie des variations.

La théorie des variations et la MSP

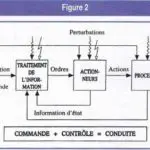

Un autre courant de la pensée statistique est apparu à la même époque et dans les mêmes conditions. Son inventeur est Walter Shewhart, un chercheur américain qui travaillait aux Bell Telephone Laboratories à New-York. En 1924, la direction technique de cette société avait formé un département d’assurance qualité dont le but était d’optimiser la production de l’usine tout en satisfaisant les besoins des clients (ce qui était novateur, à l’époque !).

Aucune autre société au monde n’avait un département de ce genre. Tous ses membres étaient de jeunes docteurs ès sciences issus des meilleures universités. Shewhart fut chargé d’étudier le problème de l’utilisation de séries de données pour améliorer les processus de production.

Publiées en 1931, les conclusions de l’étude de Shewhart sont à l’origine de la MSP, et plus généralement de la théorie des variations. La MSP est fondée sur un nouveau concept, celui de l’état stable. Il est indispensable de bien connaître ce concept pour utiliser correctement la méthode ; prenons donc ici le soin de l’expliquer.

Supposons que l’on enregistre une série de résultats concernant une opération répétitive, par exemple les ventes hebdomadaires d’une société commerciale. Les résultats seront portés sur un graphique dans l’ordre chronologique. Une première définition consiste à dire que la série est dans un état stable quand le fait d’obtenir une série de même profil par des tirages aléatoires dans une population homogène n’est pas une chose exceptionnelle. Bien entendu, cette définition » physique » de l’état stable, correspondant à notre intuition, n’est pas utilisable en pratique.

D’autre part le terme » exceptionnel » n’est pas satisfaisant pour un esprit scientifique. C’est pourquoi Shewhart a fixé des critères de stabilité – ou plutôt d’instabilité – qui se calculent à partir des valeurs numériques de la série expérimentale. Le nombre de points requis doit être au moins égal à 30. En appelant m la moyenne et s l’écart type de la série, les deux principaux critères d’instabilité sont :

- un point est en dehors de l’intervalle [(m – 3s), (m + 3s)] ;

- huit points successifs sont du même côté de la moyenne.

Un système stable se présente comme un système dont les performances sont prévisibles, puisque les données sont distribuées de façon aléatoire autour d’une moyenne. Au contraire un système instable est absolument imprévisible, mathématiquement parlant.

Il en résulte que la stabilité est une chose éminemment souhaitable, et qu’elle doit être recherchée comme un facteur d’économie. On comprend bien, par exemple, que la stabilité des ventes d’une société de distribution permet de mieux gérer les stocks. La stabilité est également le point de départ de toute amélioration rationnelle.

La méthode proprement dite se compose de deux parties. La première consiste à porter un jugement sur la stabilité de la caractéristique considérée ; la seconde à remédier, le cas échéant, aux causes d’instabilité. Le jugement sur la stabilité entraîne deux approches différentes et complémentaires :

a) système instable. Stratégie d’action intensive pour identifier le plus tôt possible les causes d’instabilité, puis les éliminer autant que possible, ou au moins y remédier ;

b) système stable. Stratégie de veille pour détecter des signes éventuels d’instabilité. Il est possible également dans un tel système de déplacer la moyenne et de diminuer la variabilité, pour des raisons économiques.

Tout l’intérêt de la MSP réside dans le choix d’une stratégie efficace. Des problèmes existent aussi bien dans un système stable que dans un système instable, mais dans le premier cas ils sont imputables au système lui-même, alors que dans le second ils sont imputables à des événements particuliers.

C’est pourquoi, face à un problème, celui qui ne connaît pas la méthode risque de faire deux types d’erreurs. Adopter une stratégie d’action intensive dans un système stable, c’est rechercher des causes qui n’existent pas ; adopter une stratégie de veille dans un système instable, c’est négliger des occasions favorables pour améliorer le système.

Certaines personnes ayant le sens des variations savent adopter d’instinct la bonne stratégie, mais dans le doute il est toujours préférable de porter quelques données sur un graphique et d’utiliser les critères d’instabilité.

L’interaction entre statistique et psychologie

La statistique analytique, malgré l’obstination de beaucoup de statisticiens à ne considérer que son aspect mathématique, est inséparable de la psychologie. Par exemple, l’expression » degré de confiance » qui revient si souvent dans les cours de statistique est manifestement le reflet de notre psychologie. Il faut être bien naïf pour croire que l’analyse de variance ou la MSP conduisent à des décisions parfaitement objectives. C’est pourquoi les entreprises qui veulent les appliquer de façon mécanique, comme des » boîtes à outils « , ne peuvent en tirer aucun profit.

La psychologie est aussi importante dans la MSP que dans l’analyse de variance. L’application de la MSP est généralement une action collective. Si la première partie de la méthode est faite correctement (ce qui n’est pas toujours le cas), un problème apparaîtra dans la seconde partie quand il faudra décider de la façon de rechercher les causes d’instabilité. Certains responsables s’opposeront peut-être à ce qu’une investigation soit faite dans leur département. Un autre problème se posera ensuite pour éliminer la cause d’instabilité. La direction refusera peut-être, contre l’avis des ingénieurs, de faire un investissement important mais nécessaire. Ce sont des problèmes psychologiques et politiques qu’il faut surmonter sous peine d’échec.

La MSP et l’analyse de variance sont complémentaires. La théorie de l’information montre que l’analyse de variance ne peut s’appliquer que sur un système stable ; dans ce cas elle sera utilisée pour améliorer les performances en déplaçant la moyenne et en diminuant la variabilité. La MSP ne présente pas grand intérêt en agronomie, en médecine ou en biologie, parce que les systèmes étudiés sont généralement stables au départ4. Dans l’industrie au contraire, où les systèmes ont tendance à être instables, la MSP est absolument nécessaire pour ouvrir la voie à l’analyse de variance.

Conclusion

La MSP est conçue pour donner à tous les membres d’une entreprise un langage commun qui leur permet de mieux utiliser les données recueillies sur les processus ; chacun travaille alors dans de meilleures conditions.

Cette méthode n’est pas réservée à des spécialistes ; on peut même remarquer qu’elle est vouée à l’échec chaque fois que des spécialistes en font une chasse gardée.

Elle est à la portée de tous, et chacun doit apprendre à la pratiquer de façon intelligente. Un soutien permanent de la direction générale est nécessaire. En retour, la direction générale aura une meilleure vision de l’avenir parce qu’elle aura affaire plus souvent à des systèmes stables.

_______________________________

1. Les sociétés françaises utilisent habituellement le sigle MSP, mais celles qui travaillent en partenariat avec des sociétés étrangères utilisent plutôt le sigle SPC.

2. Nous n’abordons pas ici les méthodes d’aide à la décision inspirées de la théorie des jeux, qui sont utiles dans certaines situations mais ne nous concernent pas directement.

3. D’autres méthodes sont utilisées parallèlement à l’analyse de variance : les régressions, les corrélations, l’analyse de covariance, etc.

4. Mais de nos jours, où l’on s’interroge sur la stabilité du climat, la MSP présente un regain d’intérêt en agronomie et, bien sûr, en météorologie.

Derniers livres de l’auteur

Management de la qualité, Economica, 1997.

Le paradigme de la qualité, Economica, 1997.

La qualité à l’école, Economica, 1998.

Traité de la qualité, Economica, 2000.