Quand les technologies convergeront…

On peut faire remonter le projet nanotechnologique à une conférence donnée par le célèbre physicien américain Richard Feynman sous le titre « There’s Plenty of Room at the Bottom ». C’était en 1959, au California Institute of Technology, et Feynman y conjecturait qu’il serait bientôt possible d’envisager la manipulation de la matière au service des fins humaines à l’échelle de la molécule, en opérant atome par atome. Le projet d’une ingénierie à l’échelle nanométrique3 était ainsi lancé.

Ces deux dernières décennies, des découvertes scientifiques et des percées technologiques prodigieuses ont vu le jour, qui semblent montrer que ce projet est aujourd’hui à la portée des scientifiques et des ingénieurs. Citons, sans souci d’exhaustivité, la mise au point du microscope à effet tunnel4 par deux physiciens du centre de recherche d’IBM de Zurich, lequel microscope permet non seulement de « voir » à l’échelle atomique mais aussi de déplacer des atomes à volonté (1982−1989) ; la découverte, qui devait lui valoir le prix Nobel en 1996, que le chimiste américain Richard Smalley5 fit des fullerènes6, structures composées d’atomes de carbone disposés en treillis sur une sphère de la taille du nanomètre, structures qui à leur tour se composent pour donner des nanotubes de carbone, sortes d’éléments d’échafaudage qui permettent d’envisager de construire à l’échelle nanométrique des matériaux extrêmement résistants, légers et bon marché ; les premières réalisations en computation quantique, laquelle pourrait révolutionner la puissance de calcul des ordinateurs en jouant, contrairement aux circuits électroniques actuels, sur le principe quantique de superposition des états (2002) ; la découverte qu’il est possible d’enrichir l’alphabet du code génétique de nouvelles bases, ce qui permet à la machinerie cellulaire productrice d’amino-acides de fabriquer des protéines que la Nature à elle seule n’aurait jamais pu produire (2002) ; etc.

Le principal argument en faveur des nanotechnologies, qui explique que, s’il est conceptuellement, physiquement, industriellement et économiquement viable, leur développement paraît inéluctable, est que ces nouvelles techniques se présentent comme les seules qui puissent résoudre, en les contournant, les difficultés immenses qui se trouvent sur la route des sociétés industrielles et postindustrielles. Les problèmes liés à l’épuisement prévisible des ressources naturelles, à commencer par les sources d’énergie fossile, mais aussi les ressources minières, les problèmes d’environnement (réchauffement climatique, pollution de l’air et de l’eau, encombrements de toutes sortes liés à l’urbanisation effrénée, etc.), les problèmes liés à la tiers-mondialisation de la planète et à la misère d’une proportion croissante de celle-ci, tous ces problèmes et bien d’autres seront en principe non pas résolus par l’avènement des nanotechnologies, mais ils deviendront caducs, obsolètes. On fera tout simplement les choses autrement, d’une manière radicalement différente. Ce que l’argument omet de dire, c’est que de nouveaux problèmes émergeront, en comparaison desquels les difficultés actuelles apparaîtront rétrospectivement comme négligeables.

Une première convergence, prometteuse : les nanotechnologies de l’information et de la communication

Depuis 1959, date de l’invention du circuit intégré, la fameuse « loi de Moore » s’est trouvée vérifiée : tous les dix-huit mois, le nombre de transistors qui peuvent être fabriqués et installés sur une puce a doublé. On est ainsi passé en quarante ans d’un transistor sur une puce primitive à 100 millions de composants actifs sur les puces actuelles. On atteindra cependant dans les dix ans qui viennent les limites physiques, économiques et en termes d’ingénierie, de la technologie du silicium. Or, si on veut bien considérer les systèmes vivants comme des machines computationnelles, on voit que la nature a su créer des structures hiérarchisées qui intègrent le calcul et la communication des informations jusqu’au niveau subnanométrique, celui des atomes. Il est donc loisible d’extrapoler la loi de Moore.

Cependant, cette nouvelle électronique ne pourra voir le jour que par une révolution dans la conception et dans les techniques de fabrication des composants, et, en deçà, dans la philosophie même de ce que sont le calcul et la communication. La nouvelle électronique sera moléculaire, c’est-à-dire que ce seront les molécules elles-mêmes qui serviront « d’interrupteurs » électroniques. La lithographie sera remplacée par la maîtrise des mécanismes d’auto-assemblage moléculaires. Plus loin encore, on peut espérer contrôler les électrons à l’unité, mais aussi les photons. Les spins eux-mêmes peuvent être traités comme des systèmes physiques incorporant une information binaire, donc aptes à incarner une mémoire et à stocker et à transmettre de l’information. Le nanomagnétisme, quant à lui, conçoit des mémoires stables sans besoin d’une alimentation électrique, ce qui révolutionnera l’électronique portable.

Ce ne sont que des exemples. Ils ont en commun que le concept d’information y apparaît comme radicalement transformé. Aux échelles dont nous parlons, la physique classique doit faire place à la physique quantique. Aussi bien, l’unité élémentaire d’information, le bit, ne correspond plus au choix entre deux possibilités disjointes et également probables, mais à la superposition de deux états de la fonction d’onde. Nous sommes dans un tout autre univers conceptuel, et donc technique.

Certaines estimations envisagent que les performances (capacités, vitesses, etc.) pourront être accrues à terme dans une proportion de 109 – c’est-à-dire qu’en termes de performances, notre univers est nanométrique par rapport à celui qui se profile à l’horizon. Imaginons seulement ce que serait un accès aux services offerts par le Web 104 plus rapide ; la mise en réseau globale des informations relatives aux personnes et aux choses par des liens à très forte capacité et à très faible consommation d’énergie via des nœuds espacés d’un mètre et non pas d’un kilomètre ; des capacités énormes de calcul et de traitement de l’information incarnées dans des dispositifs à très faible volume, comme les montures d’une paire de lunettes, etc. Donc un univers caractérisé par l’ubiquité des techniques de l’information, tous les objets constituant notre environnement, y compris les parties de notre corps, échangeant en permanence des informations les uns avec les autres. Les conséquences sociales seraient « phénoménales », tous les experts en tombent d’accord. Elles poseraient des problèmes non moins phénoménaux, liés en particulier à la protection des libertés et droits fondamentaux.

Une seconde convergence, problématique : les nanobiotechnologies

La révolution dans notre conception de la vie qu’a introduite la biologie moléculaire fait de l’organisation vivante le modèle par excellence d’une « nanotechnologie naturelle » qui fonctionne admirablement bien. Qu’est-ce qu’une cellule dans cette vision des choses sinon une nano-usine faite de nanomachines moléculaires capables d’autoréplication, voire d’autocomplexification ? Les propriétés d’auto-assemblage des virus ou de l’ADN ; le rôle que jouent dans le métabolisme cellulaire des molécules fonctionnant comme des engins macroscopiques, ayant les fonctions qui d’une roue, qui d’un fil, qui d’un interrupteur, le tout fonctionnant au moyen de « moteurs » alimentés par énergie chimique, optique ou électrique ; les connexions qui se réalisent spontanément entre les molécules du système nerveux pour traiter et transmettre l’information : autant d’exemples qui prouvent que la nature, avec le vivant, a « su créer » de l’organisation. Puisque la nature n’est pas un sujet, le terme technique que l’on utilise pour décrire ce prodige est celui d’auto-organisation.

Le projet nanotechnologique entend rivaliser avec la nature. Ce que celle-ci a fait, l’homme, qui lui est un sujet, doté d’intelligence, doit pouvoir le faire aussi bien, et peut-être mieux. Il faut rappeler que ce projet démiurgique a été lancé comme on lance, dans le commerce, un produit de grande consommation, par Eric Drexler, qui était dans les années quatre-vingt étudiant de doctorat au MIT sous la direction de Marvin Minsky, l’un des fondateurs de l’intelligence artificielle. Drexler publia en 1986 un livre programme, Engines of Creation7. C’est avec beaucoup de scepticisme et même d’ironie que la communauté scientifique, et encore plus le monde des affaires et de l’industrie, accueillirent d’abord les utopies visionnaires de Drexler. Les choses devaient changer du tout au tout en l’espace de quelques années.

Désormais établi à Palo Alto, en Californie, au sein d’un Foresight Institute qui se consacre énergiquement à la promotion des nanotechnologies, Drexler organise chaque année des congrès mondiaux qui obtiennent un succès de plus en plus marqué. Or, pour le Foresight Institute, les nanotechnologies au sens fort ne naîtront vraiment que lorsque l’homme sera capable de réaliser une nanomachinerie artificielle, inspirée ou non de l’auto-organisation biologique. Le temps viendra, prophétise Drexler, où nous pourrons tout demander à des nanopuces, nanorobots, nano-assembleurs ou nanomachines mus par des nanomoteurs, que nous aurons conçus.

Beaucoup de scientifiques tiennent ouvertement le programme de Drexler pour une utopie, voire une fumisterie8, alors même qu’ils empochent sans sourciller les mannes budgétaires que l’opération de marketing du Foresight Institute a fait pleuvoir sur eux ! J’y reviendrai.

Mais les nanotechnologues sérieux ne reculent pas devant l’idée de se servir du vivant et de ses propriétés d’auto-organisation, d’autoréplication et d’autocomplexification pour le mettre au service des fins humaines. Un premier type de démarche consiste à extraire du vivant les nanomachines qu’il a su engendrer avec ses seules ressources et, les associant à des supports ou à des systèmes artificiels, à les faire travailler pour nous. On peut ainsi tirer profit des propriétés remarquables des acides nucléiques et des protéines, en concevant des biopuces et des biocapteurs capables de détecter la présence de gènes mutants, de micro-organismes ou de fragments d’ADN, en jouant sur les affinités spécifiques de ces molécules avec une sonde fixée sur la puce.

On pourrait confier l’assemblage de nanocircuits électroniques complexes à de l’ADN, tirant parti de ses facultés d’auto-assemblage. Cette « bioélectronique » pourrait déboucher à terme sur la conception d’ordinateurs biologiques. L’arraisonnement de la vie aux fins de l’homme peut aller jusqu’à modifier le génome d’insectes volants pour en faire des machines utiles à l’industrie et à la guerre.

Une autre démarche vise à réaliser des fonctions biologiques en associant les savoir-faire du génie génétique et de la nanofabrication. L’artefact vient ici au service du vivant pour l’aider à mieux fonctionner. Cette démarche est d’esprit plus traditionnel – que l’on songe aux pacemakers et prothèses de toutes sortes – mais l’échelle nanométrique crée des défis considérables. On sait déjà fabriquer des globules rouges artificiels beaucoup plus efficaces que ceux dont la nature nous a dotés dans l’approvisionnement de nos tissus en oxygène. Les perspectives thérapeutiques s’annoncent « extraordinaires », pour reprendre le terme le plus utilisé par des rapports officiels d’ordinaire plus mesurés dans leurs propos. La guérison du cancer et du Sida est peut-être à l’horizon, si l’on arrive à fabriquer des nanovésicules intelligentes qui sauront cibler dans l’organisme les cellules malades et leur porter sélectivement des coups mortels.

En s’unissant aux biotechnologies, les nanotechnologies en démultiplient l’ambition. Les biotechnologies prennent les produits de l’évolution biologique pour donnés et se contentent de les utiliser ou de les reproduire pour les mettre au service des fins humaines. Le projet nanotechnologique est beaucoup plus radical. Il part du constat que l’évolution est un piètre ingénieur, qui a fait son travail de conception plus ou moins au hasard, se reposant sur ce qui marchait à peu près pour échafauder de nouvelles constructions plus ou moins branlantes – bref, en bricolant. L’esprit humain, relayé par les technologies de l’information et de la computation qui le dépasseront bientôt en capacités d’intelligence et d’imagination, fera beaucoup mieux.

Une troisième convergence, essentielle : l’esprit des nanotechnologies est dans les sciences cognitives

En arrière-fond de tout « paradigme » scientifique, il y a ce que Karl Popper appelait un « programme métaphysique de recherches » – ensemble non « testable » de propositions que l’on tient pour vraies sans chercher à les remettre en cause, cadre théorique qui limite le type de questions que l’on pose mais aussi qui en donne l’inspiration première. Le paradigme « nano » procède de la même métaphysique que les sciences cognitives. Celle-ci peut se dire ainsi : tout dans l’univers, donc la nature, la vie et l’esprit, est machine informationnelle, dite encore algorithme9.

Chronologiquement, et contrairement peut-être à certaines idées reçues, c’est d’abord l’esprit (mind) qui a été assimilé à un algorithme (ou machine de Turing : modèle de McCulloch et Pitts, 1943) ; puis ce fut le tour de la vie, avec la naissance de la biologie moléculaire (Max Delbrück et le groupe du Phage, 1949) ; et, seulement plus tard, la thèse que les lois de la physique sont récursives (ou Turing-computables). Une fois admise une telle vision du monde, il n’y a qu’un pas pour en arriver à former le projet de se rendre maître de ces machines, d’abord en les simulant et en les reproduisant (naissance de l’intelligence, puis de la vie artificielles), ensuite en intervenant sur elles à la manière de l’ingénieur (biotechnologies, technologies cognitives, etc.).

Un second courant des sciences cognitives, issu des réflexions de John von Neumann, a engendré les sciences de la complexité et de l’auto-organisation. L’ingénierie qui en résulte est très différente de la conception classique. Dans cette dernière, il s’agit de concevoir et de réaliser des structures dont le comportement reproduira les fonctionnalités que l’on juge désirables. L’ingénieur de la complexité, lui, « se donne » des structures complexes (éventuellement en les puisant dans le réservoir que nous offrent la nature et la vie, par exemple un cerveau humain, ou bien en les reproduisant artificiellement, par exemple sous la forme d’un réseau de neurones formels) et explore les fonctionnalités dont elles sont capables, en essayant de dégager le rapport structure/fonction : démarche ascendante (bottom-up) donc, et non pas descendante (top-down).

L’industrie du software repose déjà en partie sur ce retournement. La recherche sur les algorithmes génétiques consiste à simuler les capacités évolutives d’une « soupe » primitive constituée de programmes d’ordinateur, les plus performants se reproduisant davantage que les autres. On obtient ainsi des algorithmes très performants en effet, puisqu’ils ont été « sélectionnés » selon ce critère, mais on est dans l’incapacité de comprendre pourquoi ils ont ces propriétés.

Le double langage de la science, et pourquoi celle-ci est devenue une des activités humaines les plus dangereuses

Cet article prend maintenant un tour plus personnel. Après l’exposé des faits vient le temps du jugement et de l’engagement.

Les promoteurs des nanosciences et des nanotechnologies sont nombreux, puissants et influents : les scientifiques et les ingénieurs enthousiasmés par la perspective de percées fabuleuses ; les industriels attirés par l’espoir de marchés gigantesques ; les gouvernements des nations et des régions du globe terrorisés à l’idée de perdre une course industrielle, économique et militaire très rapide où vont se jouer les emplois, la croissance, mais aussi les capacités de défense de demain ; et, enfin, les représentants de ce vaste sujet collectif et anonyme qu’est la fuite en avant technologique où la technique apparaît seule capable de contenir les effets indésirables et non voulus de la technique.

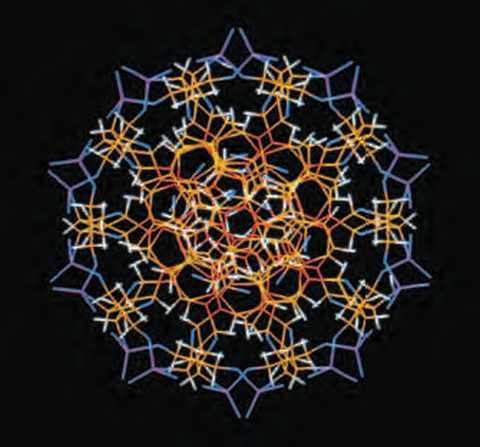

L’ADN est la molécule support de l’hérédité. Sur cette vue transversale d’un modèle de la molécule, les divers atomes constituant la molécule ont été représentés en couleur : le carbone en orange, l’oxygène en bleu, l’azote en rouge, l’hydrogène en blanc et le phosphore en violet. © INSERM, PHOTO MARTIN J.-L./LAMBRY J.-C.

On se s’étonne donc pas que soient vantés partout en termes hyperboliques les bienfaits pour l’humanité de la révolution scientifique et technique en cours. Le rapport américain de la National Science Foundation (NSF) par lequel j’ai commencé, et dont le titre complet est Converging Technologies for Improving Human Performances, bat sans doute tous les records. Il ne promet pas moins à terme que l’unification des sciences et des techniques, le bien-être matériel et spirituel universel, la paix mondiale, l’interaction pacifique et mutuellement avantageuse entre les humains et les machines intelligentes, la disparition complète des obstacles à la communication généralisée, en particulier ceux qui résultent de la diversité des langues, l’accès à des sources d’énergie inépuisables, la fin des soucis liés à la dégradation de l’environnement.

Prudemment, le rapport conjecture que : « L’humanité pourrait bien devenir comme un “cerveau” unique, [dont les éléments seraient] distribués et interconnectés par des liens nouveaux parcourant la société. » On reçoit cependant un choc en découvrant que l’un des deux responsables de la publication, William Sims Bainbridge, technocrate influent de la NSF, milite dans la vie civile dans une secte qui prêche le « transhumanisme », c’est-à-dire le dépassement de l’imparfaite espèce humaine par une cyber-humanité. Celle-ci pourra accéder à l’immortalité lorsqu’on saura transférer le contenu informationnel du cerveau, « donc » l’esprit et la personnalité de chacun, dans des mémoires d’ordinateur. On ne s’amuse plus du tout lorsqu’on apprend que, prévoyant des résistances de la part des institutions et des élites « traditionnelles », à commencer par les religions établies, M. Bainbridge en appelle quasiment à la rébellion armée10.

Quelques chercheurs de base sont assez lucides pour comprendre ceci. À trop vanter les conséquences positives « fabuleuses » de la révolution en cours, on s’expose à ce que des critiques non moins hypertrophiées s’efforcent de la tuer dans l’œuf. Si l’on prend au sérieux le programme de Drexler, alors on ne peut pas ne pas s’effrayer des risques inouïs qui en résulteraient11. Le succès du dernier roman de Michael Crichton, Prey, a rendu célèbre dans toute l’Amérique le risque de gray goo, dit encore d’écophagie globale : le risque d’une autoréplication sauvage des nanomachines chères au Foresight Institute, à la suite d’un accident de programmation. Tout ou partie de la biosphère serait alors détruit par épuisement du carbone nécessaire à l’autoreproduction des nano-engins en question. Ce risque ne peut vraiment effrayer que celui qui croit à la possibilité de telles machines. Il suffit de nier cette possibilité pour écarter le pseudo-risque d’un haussement d’épaules.

La directrice du projet NanoBio du CEA à Grenoble, l’un des fleurons de la nanobiotechnologie française, écrit à ses troupes : » Je ne pense pas qu’un scientifique normal se reconnaisse dans les visions de Drexler. » Il faut donc en conclure que l’actuel directeur du département » sciences physiques et mathématiques » du CNRS, Michel Lannoo, éminent physicien, spécialiste des semi-conducteurs et l’un des principaux artisans du développement des nanosciences en France, est un scientifique anormal. En introduction à un numéro spécial du journal du CNRS de l’été 2002, consacré au » nanomonde « , il déclarait en effet : » L’œuvre d’Eric Drexler m’a beaucoup influencé. J’ai acheté 25 exemplaires d’un de ses livres, Engines of Creation, pour que chacun des membres de mon laboratoire le lise. »

La vérité est que la communauté scientifique tient un double langage, ainsi qu’elle l’a souvent fait dans le passé. Lorsqu’il s’agit de vendre son produit, les perspectives les plus grandioses sont agitées à la barbe des décideurs. Lorsque les critiques, alertés par tant de bruit, soulèvent la question des risques, on se rétracte : la science que nous faisons est modeste.

Le génome contient l’essence de l’être vivant mais l’ADN n’est qu’une molécule comme une autre – et elle n’est même pas vivante ! Grâce aux OGM, on va résoudre une fois pour toutes le problème de la faim dans le monde, mais l’homme a pratiqué le génie génétique depuis le Néolithique. Les nanobiotechnologies permettront de guérir le cancer et le Sida, mais c’est simplement la science qui continue son bonhomme de chemin. Par cette pratique du double langage, la science ne se montre pas à la hauteur de ses responsabilités.

La science ne pense pas, disait Heidegger. Il ne voulait évidemment pas dire que les scientifiques sont tous des imbéciles. La thèse est que, par constitution, la science est incapable de ce retour réflexif sur elle-même qui est le propre de toute activité humaine responsable. Le débat sur les nanotechnologies, déjà intense aux États-Unis, encore au stade embryonnaire en France, a toutes chances de dégénérer dans la confusion. Il va être, il est déjà presque impossible de réfléchir.

Dans la mesure où il n’est pas trop tard, j’aimerais faire quelques suggestions. D’abord, ne pas se laisser emprisonner dans la problématique des risques, les analyses coûts – avantages et autre principe de précaution. Non pas que le développement des nanotechnologies soit sans danger ! Mais le danger est d’une nature telle qu’il est vain de chercher à l’appréhender par les méthodes classiques. Multiplier des perspectives de dommages par des probabilités subjectives est une démarche dérisoire lorsqu’il s’agit d’apprécier des effets qui peuvent aller, à en croire les thuriféraires, jusqu’à un « changement de civilisation« 12.

La question essentielle est la suivante : comment expliquer que la technoscience soit devenue une activité si « risquée » que, selon certains scientifiques de premier plan, elle constitue aujourd’hui la principale menace à la survie de l’humanité13. Les philosophes répondent à cette question en disant que le rêve de Descartes – se rendre maître et possesseur de la nature – a mal tourné. Il serait urgent d’en revenir à la « maîtrise de la maîtrise ». Ils n’ont rien compris. Ils ne voient pas que la technoscience qui se profile à l’horizon, par « convergence » de toutes les disciplines, vise précisément à la non-maîtrise. L’ingénieur de demain ne sera pas un apprenti sorcier par négligence ou incompétence, mais par finalité. Il se « donnera » des structures ou organisations complexes et il se posera la question de savoir ce dont elles sont capables, en explorant le paysage de leurs propriétés fonctionnelles – démarche « ascendante », comme on l’a vu. Il sera au moins autant un explorateur et un expérimentateur qu’un réalisateur. Ses succès se mesureront plus à l’aune de créations qui le surprendront lui-même que par la conformité de ses réalisations à des cahiers des charges préétablis.

Des disciplines comme la vie artificielle, les algorithmes génétiques, la robotique, l’intelligence artificielle distribuée répondent déjà à ce schéma. Comme, par ailleurs, le savant sera de plus en plus celui qui, non pas découvre un réel indépendant de l’esprit, mais explore les propriétés de ses inventions (disons le spécialiste d’intelligence artificielle plutôt que le neurophysiologiste), les rôles de l’ingénieur et du savant tendront à se confondre.

Un regroupement de centres de recherches européens s’est donné pour nom NanoToLife – abréviation de Bringing Nanotechnology to Life. L’ambivalence de l’expression est un chef-d’œuvre de ce double langage que je dénonçais ci-dessus. Elle peut signifier, modestement, dans une attitude de retrait, « Faire venir les nanotechnologies à l’existence », ou bien encore « Rapprocher les nanotechnologies des sciences de la vie ». Mais on ne peut pas ne pas y entendre le projet démiurgique de fabriquer de la vie au moyen de la technique. Et celui qui veut fabriquer – en fait, créer – de la vie ne peut pas ne pas ambitionner de reproduire sa capacité essentielle, qui est de créer à son tour du radicalement nouveau.

Le lobby nanotechnologique a actuellement peur. Il a peur que son opération de relations publiques aboutisse à un ratage encore plus lamentable que celui qu’a connu le génie génétique. Avec la conférence d’Asilomar en 1975, les choses avaient pourtant bien commencé. La communauté scientifique avait réussi à se donner le monopole de la régulation du domaine. Trente ans plus tard, le désastre est accompli. La moindre réalisation biotechnologique fait figure de monstruosité aux yeux du grand public. Conscients du danger, les nanotechnologues cherchent une issue du côté de la « communication » : calmer le jeu, rassurer, assurer « l’acceptabilité ». Ce vocabulaire de la pub a quelque chose d’indécent dans la bouche des scientifiques.

Que faire ? Il serait naïf de croire que l’on pourrait envisager un moratoire, ou même, à court terme, un encadrement législatif ou réglementaire, lequel, en tout état de cause, ne pourrait être que mondial. Les forces et les dynamiques à l’œuvre n’en feraient qu’une bouchée. Le mieux que l’on puisse espérer est d’accompagner, à la même vitesse que leur développement et, si possible, en l’anticipant, la marche en avant des nanotechnologies, par des études d’impact et un suivi permanent, non moins interdisciplinaires que les nanosciences elles-mêmes. Une sorte de mise en réflexivité en temps réel du changement scientifique et technique serait une première dans l’histoire de l’humanité. Elle est sans doute rendue inévitable par l’accélération des phénomènes.

Une chose est certaine : la question de la responsabilité de la science est devenue beaucoup trop grave pour qu’on laisse le soin d’en débattre aux seuls scientifiques.

____________________________________________

Jean-Pierre DUPUY dirige au sein de l’Ecolele Groupe de Recherche et d’Intervention sur la Science et l’Éthique [GRISÉ].

2. Le rapport est accessible sur la Toile à http://www.wtec.org/ConvergingTechnologies

3. Rappelons que « nano » signifie 10-9. Un nanomètre est un milliardième de mètre, soit encore un millionième de millimètre. Un brin d’ADN fait quelques nanomètres de long ; un atome de silicium est à l’échelle de quelques dixièmes de nanomètres.

4. Scanning Tunnelling Microscope [STM]. “ L’effet tunnel » est un effet quantique, en vertu duquel des électrons traversent le vide qui sépare d’une surface à observer la pointe de platine ou de tungstène du microscope – ce qui serait inconcevable en physique classique.

5. En collaboration avec Harry Kroto et Robert Curl qui partagèrent le prix Nobel avec Richard Smalley.

6. Dites encore buckyballs, ces deux appellations se référant au visionnaire Buckminster Fuller et à ses coupoles géodésiques.

7. Livre disponible sur le site du Foresight Institute à : < http://www.foresight.org >

8. C’est le cas de Richard Smalley. À ceux qui affirment étourdiment que le programme de Drexler “ violerait les lois de la physique ”, il est trop facile à ce dernier de répliquer que, dans ce cas, la vie elle-même violerait les lois de la physique !

9. Je me permets de renvoyer le lecteur à mon The Mechanization of the Mind. On the Origins of Cognitive Science, Princeton University Press, 2000.

10. Le lecteur pourra juger par lui-même en consultant le site http://www.transhumanism.com/articles_more. php?id=P697_0_4_0_C

11. Voir le rapport du groupe ETC – qui fit naguère plier Monsanto sur les OGM –, The BigDown, accessible sur la Toile à < http://www.etcgroup.org/documents/TheBigDown.pdf >

ETC a déposé un projet de moratoire sur les nanotechnologies à la conférence de Johannesburg, qui n’a évidemment pas été retenu.

12. Cf. mon Pour un catastrophisme éclairé, Seuil, 2002.

13. Cf. la mise en garde, très remarquée et discutée, de l’un des informaticiens américains les plus brillants, Bill Joy, parue dans la revue très » branchée « , Wired, sous le titre éloquent : « Why the future doesn’t need us » (avril 2000). Le sous-titre précise : » Our most powerful 21st century technologies – robotics, genetic engineering, and nanotech – are threatening to make humans an endangered species. » Voir aussi le livre de l’astronome royal britannique, Sir Martin Rees, Our Final Hour. A Scientist’s Warning : How Terror, Error, and Environmental Disaster Threaten Humankind’s Future in this Century – on Earth and Beyond, Basic Books, New York, 2003.