Les maths au service de la gestion d’actifs

La gestion d’actifs est un domaine où l’utilisation des mathématiques est fondamentale. Cela n’est pas une surprise puisqu’on n’y parle en fait presque que de chiffres. Nous allons dans cet article montrer quels types d’outils et de modèles sont utilisés, et comment ces techniques ont évolué au cours du temps.

© Elenathewise

Au dix-neuvième et au début du vingtième siècle, la gestion d’actifs est alors réduite à la gestion de portefeuilles d’actions et d’obligations gérés de façon très statique. Confrontés au maquis que constitue l’univers des actions, les gérants ont constaté que le concept de diversification est fondamental, et qu’il est essentiel pour appréhender l’évolution globale de l’univers des actions de créer une synthèse de l’ensemble des prix. C’est ainsi qu’apparaît la notion d’indice boursier avec la création de l’indice Dow Jones.

REPÈRES

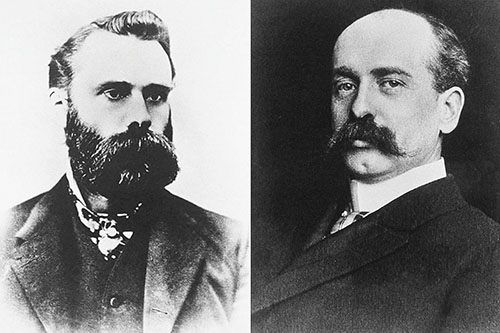

En 1884, Charles Dow et Edward Jones créent l’indice Dow Jones, reflet des actions industrielles américaines. Il valait initialement 40 points contre près de 25 000 aujourd’hui. C’était un indice assez rudimentaire puisque composé d’un petit nombre d’actions (trente) et ne prenant pas en compte les dividendes. Pour la petite histoire, l’indice fut pendant longtemps calculé heure par heure à la main et il ne fut informatisé qu’en 1963 !

Charles Dow et Edward Jones.

La théorie moderne du portefeuille

La théorie moderne du portefeuille est un concept développé en 1952 par Harry Markowitz. Dans ce modèle, le rendement d’un actif est une variable aléatoire. Un portefeuille est la somme pondérée de différents actifs et par conséquent, le rendement d’un portefeuille est également une variable aléatoire qui possède une espérance et une variance (l’espérance est la valeur que l’on s’attend à trouver en moyenne, et la variance est la dispersion moyenne autour de cette espérance, c’est-à-dire sa variabilité). Un investisseur rationnel va optimiser les caractéristiques de son portefeuille en maximisant l’espérance du rendement sous contrainte de limitation du risque, c’est-à-dire de la variance du portefeuille. Sur le plan technique, il s’agit donc d’un problème d’optimisation quadratique assez banal. Ces bases théoriques ne seront mises en pratique que vers les années 80.

Les années 70 : les maths arrivent en force sur les marchés

Le 18 décembre 1971 marque la fin du système monétaire international défini en 1944 à Bretton Woods, et la fin des taux de change fixes. Cette période marque avec les options de change le début de l’essor des produits dérivés appliqués aux marchés financiers (ils existaient déjà sur les marchés de matières premières). Ce développement est permis par les méthodes d’analyse des processus stochastiques continus qui permettent de mettre avec le modèle de Black et Scholes un prix théorique sur les produits optionnels (options d’achat, option de vente etc.). Les produits dérivés n’intéressent pas encore les gestionnaires d’actifs, mais l’influence des maths et des statistiques sur les marchés est lancée.

Depuis 80 : début de la gestion quantitative

Les statisticiens commencent à structurer la gestion avec l’apparition de concepts qui deviendront vite incontournables : tout d’abord, la notion d’indice s’étend à tout type de portefeuille et il devient vite évident que toute activité de gestion commence par la définition d’un indice de référence (benchmark), et que la qualité d’un gérant se mesurera à sa capacité à faire mieux que son indice de référence (« battre son benchmark »). Une autre innovation est l’arrivée de la notion de volatilité, qui n’est autre que l’écart-type de l’évolution du prix. Ce concept, tout droit issu des modèles d’options, séduit rapidement. Il introduit la notion de risque dans la gestion, ou plus exactement, il permet de commencer à chiffrer le risque. Ce concept est à l’heure actuelle toujours central dans la gestion, notamment dans la réglementation qui y fait explicitement référence. Cette notion de volatilité est évidemment un peu rustique car elle suppose une distribution gaussienne de variations de prix, ce qui est assez loin de la réalité des marchés, et elle suppose également une indépendance des variations de prix, même entre des dates proches, ce qui n’est pas conforme à ce qu’on observe en réalité.

L’inexorable développement des hedge funds

C’est également à ce moment que se développent les hedge funds, qui utilisent la panoplie complète des techniques disponibles : levier, vente à découvert, arbitrages entre marchés liés puis trading automatisé, trading haute fréquence qui permettent d’exploiter toutes les inefficiences des marchés financiers, et c’est le début de la modélisation de la structure temporelle des prix : comportement d’autocorrélation, de mémoire longue (Hurst exponent), Box-Jenkins, etc. Les techniques utilisées ont été clairement basées sur des modèles d’évaluation d’actifs financiers, sur des techniques de trading plus ou moins automatisées, et ont pu utiliser à fond les principes de diversification grâce au levier. Les gérants de hedge funds sont cependant restés assez discrets sur les techniques qu’ils utilisent. Ce que l’on peut dire aujourd’hui, c’est que l’industrie des hedge funds, qui a connu un développement très important (près de 3 000 milliards de dollars actuellement), n’est plus vraiment ce qu’elle était : les techniques d’arbitrage se sont diffusées aux autres gérants et leur rendement s’est partiellement évaporé : la taille du gâteau s’est réduite, pour une taille d’actifs en gestion toujours plus importante. Les rendements sont donc moins élevés qu’avant et le bêta (c’est-à-dire la contribution) des principaux facteurs classiques (action, obligation, crédit…) à la performance est considérablement plus élevé qu’auparavant. En conséquence, la valeur ajoutée et donc l’intérêt par rapport à la gestion classique ont fortement diminué.

Depuis 90 : développement des produits garantis, gestion indicielle

Les années 90 voient apparaître en gestion d’actifs les produits garantis totalement ou partiellement, indexés sur un panier d’indices ou de titres, avec des formules d’indexation parfois complexes. La technologie qui sous-tend ces produits est là encore directement issue des méthodes de calcul d’options. Ces produits ont eu un grand succès commercial car ils donnaient le sentiment qu’on ne pouvait pas perdre. La réalité est moins favorable, et ces produits, dont certains se sont révélés décevants, ont fini leur vie devant les tribunaux, certains investisseurs estimant que les commercialisateurs leur avaient masqué les risques réels. Ces produits ont petit à petit perdu une partie de leur intérêt. En effet, ces produits sont structurés schématiquement de la façon suivante : le capital initial est réparti d’une part en une obligation qui permet de sécuriser une partie ou la totalité du capital à l’échéance, le reste permettant d’acheter une option qui offre une indexation sur un sous-jacent, sans possibilité de perte. Or les taux d’intérêt ont fortement diminué. La partie obligataire a donc pris de plus en plus de place et la partie indexation s’en est trouvée réduite.

L’engouement pour les produits basés sur des indices

Par ailleurs, on a vu se développer de façon spectaculaire les produits indiciels, structurés pour reproduire exactement un indice, moyennant des frais de gestion extrêmement bas. Là aussi, les techniques mathématiques jouent un rôle clé dans les méthodes de réplication d’un indice. On identifie différentes méthodes d’indexation, comme l’optimisation dans laquelle le gestionnaire va choisir avec des méthodes d’analyse numérique quelques titres dont le comportement se rapproche le plus possible de celui de l’indice. Ou la réplication stratifiée : chaque secteur, chaque industrie (sous-secteur), chaque taille de société (grande, moyenne ou petite) et le cas échéant chaque pays seront représentés par une ou plusieurs actions dans le portefeuille créé. Troisième méthode : la réplication totale, dans laquelle le portefeuille est composé de tous les titres de l’indice, avec la même pondération. Quatrième exemple : la mise en place d’un swap de performance avec une contrepartie (le plus souvent, une salle de marché). Le swap (contrat d’échange de performance) est un contrat par lequel la contrepartie s’engage à payer au gérant la performance de l’indice. De facto, on déplace le risque de réplication vers la contrepartie.

Benoît Mandelbrot remet totalement en question la validité des théories

de Markowitz et de Sharpe

Depuis 2000 : on comprend (enfin !) que les produits financiers ne sont pas distribués « normalement »

Benoît Mandelbrot, à travers de nombreux travaux, remet totalement en question la validité des théories de Markowitz et de Sharpe. Le problème est que les applications utilisant ce concept sont basées sur une hypothèse de distribution normale (gaussienne) des évolutions de prix, qui sous-estime très fortement les événements « improbables » comme les crises ou les krachs alors qu’ils sont finalement beaucoup moins rares que la distribution gaussienne ne le prévoit. C’est ce que l’on appelle les fat tails (épaisseur des queues de distribution). Autre problème de taille : les hypothèses néoclassiques sur lesquelles sont fondées ces théories sont très peu réalistes, notamment la rationalité des investisseurs, la continuité et l’indépendance des variations de cours…

Pourtant, le critère Espérance-Variance introduit par Markowitz ne fait, contrairement à une idée très répandue, aucune hypothèse sur le rendement des actifs, et notamment, ne suppose pas de distribution gaussienne, puisqu’il suffit d’avoir des distributions admettant des variances finies pour dérouler la modélisation de Markowitz.

Concrètement, l’industrie de la gestion d’actifs est progressivement influencée par ces évolutions théoriques : la mesure du risque est complétée par la notion de valeur en risque (VaR, value at risk) qui estime le niveau de perte à un horizon donné, qui, pour une probabilité donnée (par exemple 1 %), ne doit pas être dépassé. Ce concept permet d’appréhender les risques associés à des distributions non gaussiennes mais souffre pourtant de nombreux défauts, le plus important étant qu’il ne décrit pas ce qui se passe dans le 1 % de cas défavorables. Curieusement, le concept de CVaR (conditional value at risk) qui est l’espérance de perte dans le 1 % de cas défavorables n’a pas ce défaut, mais reste encore très sous-utilisé.

Indices intelligents

La théorie a montré que les indices classiques pondérés par les capitalisations boursières étaient adaptés à la description du marché, mais étaient sous-optimaux en termes de performance. C’est ainsi que sont apparus des indices intelligents (smart beta) qui ont vocation à surperformer les indices classiques.

Big data et IA

Les années récentes ont vu deux thèmes prometteurs apparaître.

Le big data : réseaux sociaux, bases de données massives et méthodes d’analyse adaptées à ce type de données suscitent un intérêt croissant de la part des gestionnaires d’actifs. La course aux données n’est pas un phénomène nouveau, mais alors qu’il y a dix ans les données analysées étaient essentiellement en lien direct avec les marchés, les données sont aujourd’hui beaucoup plus diverses, moins structurées et elles proviennent de sources multiples. Cependant, la qualité des données décroît avec leur quantité, et il n’est pas facile de distinguer l’information pertinente du bruit. Jusqu’ici, et pour autant qu’on le sache, ces approches n’ont pas vraiment été concluantes en gestion d’actifs, et quand bien même elles le seraient, il est vraisemblable qu’elles seraient rapidement diffusées et donc que leur valeur ajoutée s’évaporerait très vite.

Les techniques d’intelligence artificielle offrent maintenant des perspectives très intéressantes, avec d’une part les techniques de reconnaissance de forme qui permettent d’identifier des schémas (des patterns), et les approches du type deepmind avec leurs mécanismes d’autoapprentissage. C’est probablement très prometteur : nous avons vu que le programme AlphaGo pouvait battre les meilleurs joueurs professionnels du jeu de go, rien n’est donc impossible. Mon impression personnelle est que c’est cette direction qui est la plus prometteuse pour l’avenir.