Concilier pragmatisme et rigueur

Face à un problème donné, les décideurs sont amenés à s’appuyer sur des modélisations des phénomènes concernés, alors même que les données, les lois et les objectifs nécessaires pour construire et alimenter les modèles sont entachés d’incertitudes L’ingénieur qui met en oeuvre les outils mathématiques est donc conduit à concilier pragmatisme – faire avec les éléments connus – et rigueur scientifique – ne pas biaiser les résultats ou leur interprétation en occultant les limites de la modélisation.Une démarche rigoureuse et efficace vise en premier lieu à identifier toutes les incertitudes en jeu, à sélectionner les outils permettant d’obtenir rapidement et par itération un faisceau de résultats exploitables, et enfin à présenter ces derniers sous une forme qui reflète leur caractère probabiliste.

REPÈRES

Dans l’un des articles de ce numéro, Pierre Funk, de l’IRSN, explique que la France a une loi d’inventaire des matières radioactives. Fort bien, cela paraît clair. Mais en réalité, quelle précision, pour cet inventaire ?

Les matières radioactives existent dans la nature : faut-il les comptabiliser ?

Et allons-nous descendre au niveau de l’aiguille radioactive (ce qui exige des hommes et du matériel), tandis que les Russes oublient des sous-marins entiers ?

Un monde d’incertitudes

Les incertitudes, on peut le dire sans plaisanterie, sont le cauchemar de l’ingénieur et, au-delà, du décideur. L’esprit humain est satisfait lorsqu’il voit une situation bien nette, bien carrée, où tout est clair dans les hypothèses ; il ne reste qu’à calculer, et les polytechniciens s’y entendent à merveille. Il y a là un confort intellectuel où chacun se plaît : n’avoir plus que la décimale suivante à calculer, comme disaient les physiciens de la fin du XIXe siècle. Aujourd’hui encore, bon nombre d’organismes scientifiques sont complètement persuadés que les progrès, dans leur domaine, dans leur discipline, passent par des calculs plus rapides, plus précis. Ils réclament davantage de moyens : des ordinateurs plus puissants, des mailleurs plus fins. Ils sont tout contents : ils présentent des résultats, en sortie, avec seize chiffres significatifs, avec un pas de temps de la seconde. Et si on leur dit : mais les données en entrée ne sont connues que tous les mois et avec 20 % d’incertitude, ils restent éberlués ; cela choque leur mécanique intellectuelle. Puisqu’ils sont capables de fournir, en sortie, des résultats précis, il faudrait les alimenter avec des données précises. Pour eux, c’est la faute des expérimentateurs, des fournisseurs de données, qui n’ont pas fait leur boulot correctement. Les ingénieurs ne reçoivent que des données incomplètes et incertaines, alors qu’ils auraient mérité mieux. À aucun moment ils ne remettront en cause la pertinence de leur approche intellectuelle : ils restent persuadés que c’est la société qui, par manque de moyens, d’intérêt, ne leur fournit pas les aliments qui leur sont dus.

Trois sortes d’incertitudes

Or, les incertitudes existent nécessairement dans toute situation réelle. Il y a en réalité trois sortes d’incertitudes :

- - sur les données ;

- - sur les lois ;

- - sur les objectifs.

L’incertitude sur les données est la plus facile à comprendre. Quand on relève un débit, une température, une pression, chaque mesure est entachée d’une incertitude, et il arrive que des données manquent parce que quelque chose n’a pas fonctionné. L’incertitude sur les lois tient à notre ignorance des lois de la nature. Le déplacement d’une pollution, le vieillissement d’un matériau, le comportement d’un satellite sont autant de domaines où nous n’avons que des connaissances partielles, approximatives, souvent empiriques. On ne peut pas prédire avec certitude le moment où une pollution atteindra tel site, où une ampoule cessera d’éclairer, où un satellite rentrera dans l’atmosphère. L’incertitude sur les objectifs correspond à la question : que veut-on faire ? Et c’est la plus difficile, parce qu’en général il y a plusieurs objectifs, flous et contradictoires. Veut-on diminuer les coûts ? à court terme ? à long terme ? augmenter les compétences ? garder des ressources pour l’an prochain ?

Réfléchir d’abord

Une réflexion préliminaire sur les trois incertitudes : données, lois, objectifs, devrait être obligatoire avant de chercher à résoudre un problème. Malheureusement, c’est l’exception, aussi bien dans l’approche scientifique que dans la présentation des résultats. On donne un scénario, avec des résultats précis, et on « oublie » de dire que ce scénario n’est qu’un choix parmi une infinité d’autres.

Une telle démarche induit une suspicion : ce scénario n’a‑t-il pas été choisi pour prouver ce que l’on veut prouver, et tous les autres, qui divergeraient des positions attendues, n’ont-ils pas été éliminés d’office ?

Le recours à la modélisation n’est pas toujours pertinent

L’incertitude sur les lois paraît acceptable pour un esprit rationnel

L’incertitude sur les lois paraît acceptable pour un esprit rationnel. Nous savons tous qu’aux hautes vitesses, il faut tenir compte d’une correction relativiste, négligeable aux basses vitesses. Fort bien, et après ? Mais la question n’est pas du tout de l’approximation des lois de la nature ; elle tient aux choix qui sont faits dans les modèles. Prenons un exemple amusant, où les mathématiques se sont effondrées ! Nous avons une collaboration scientifique, dans le cadre d’un programme appelé » Robust Mathematical Modeling « , avec plusieurs universités, dont celle de Kent (Ohio, USA). Dans le cadre de ce programme, mes amis de Kent ont reçu le responsable d’une société de transports (plusieurs centaines de camions) qui cherchait à minimiser ses coûts, notamment d’essence. Comme l’essence, aux USA, n’a pas le même prix selon les États, cette société avait mis en place, à grands frais, un logiciel qui rapatriait les coûts selon les stations-services et calculait les meilleurs itinéraires. Cette branche des mathématiques s’appelle la » recherche opérationnelle « , et ce logiciel avait représenté un investissement de plusieurs centaines de milliers de dollars. Il ne donnait pas satisfaction, et les chercheurs de Kent avaient été consultés pour l’expertiser : quelles variables fallait-il utiliser, et comment ? Et puis le responsable de la société de transports s’est aperçu qu’il avait intérêt à négocier avec les pétroliers : si, avec mes centaines de camions, je prends de l’essence dans telle station-service, vous me consentez 10 % de réduction. Et le logiciel a fini à la poubelle, l’expertise aussi. Sur cet exemple, on s’aperçoit que les lois n’étaient pas correctement connues. Les prix, à chaque station, n’auraient pas dû être considérés comme fixes. Mais il est impossible de savoir a priori quelle fourchette de négociation est possible.

Le prix, variable volatile et irrationnelle

De manière très générale, on peut dire qu’il faut, si possible, éviter de faire intervenir les prix dans un problème d’optimisation, parce qu’il s’agit d’une variable volatile, irrationnelle, et dont les variations sont brusques et incontrôlables. Par exemple, si l’on cherche à prédire la consommation d’énergie dans dix ans, il vaut mieux le faire sur la base des besoins estimés, par secteur, à partir d’un historique : on aura une prévision relativement robuste et fiable, tandis qu’une prévision du prix du pétrole est très difficile. Bien entendu, dès que l’on touche à la prospective, l’ignorance sur les lois est la règle. À l’horizon de dix ou vingt ans, on ne peut savoir avec précision quelle sera la population, quels seront les consommations, les besoins, etc. L’attitude scientifique, répondant à un souci d’honnêteté minimale, consiste évidemment à mentionner toutes les incertitudes possibles ou à venir Ce peut être fait de diverses manières : en donnant des intervalles de confiance (probabilistes ou non) sur les différents paramètres, en adoptant des scénarios » hauts » et » bas « , etc. L’honnêteté impose aussi de distinguer entre incertitudes sur les données et incertitudes sur les modèles (c’est-à-dire sur les lois qui ont été retenues). Cela consiste à dire : dans le cadre de ce modèle, je trouve une incertitude de 10 % en sortie, mais c’est parce que j’ai supposé que les variations de tel paramètre étaient linéaires entre telle et telle borne. Sans cette hypothèse (souvent factice) de linéarité, mes incertitudes seraient différentes.

Gare au consensus d’experts

Confronter avec l’expérience

De nos jours, on entend souvent dire que les experts se sont mis d’accord pour décider que tel modèle était valide. Une telle affirmation est totalement dépourvue de valeur scientifique : un modèle ne peut être validé que par confrontation avec l’expérience, avec la réalité. Par exemple, on ne peut pas « démontrer » le réchauffement climatique au moyen de modèles.

Dans l’état actuel des choses, et en particulier dans le domaine de l’environnement, l’incer-ti-tude sur les modèles n’est presque jamais considérée, pas même mentionnée. Il se crée instantanément » un consensus d’experts « , pour utiliser telle loi à tel endroit, par exemple tel équilibre économique entre l’offre et la demande. Un tel modèle n’est jamais validé, n’est jamais confronté à l’expérience, mais il acquiert vite force de loi, par le consensus des experts, et peut ainsi servir de base à des décisions normatives. Je lis quelquefois » un modèle mathématique a démontré que… « . Une telle phrase est une absurdité. Un modèle mathématique n’est qu’une tentative de représentation de la réalité, plus ou moins précise, plus ou moins complète, qu’il faut ensuite valider, c’est-à-dire confronter à l’expérience, pour voir si le théoricien a réellement compris quelque chose. Prenez un tableau, fait par un peintre, représentant une rivière. C’est une représentation de la réalité, qui en vaut bien une autre. Mais vous ne diriez pas : ce tableau prouve que l’on peut traverser la rivière à gué.

La réduction des incertitudes peut s’avérer ruineuse et stérile

On peut toujours, évidemment, réduire les incertitudes sur n’importe quoi, mais cela coûte des ressources, qui pourraient être mieux employées ailleurs. Le combat pour la réduction à tout prix n’est pas sain, de même que le combat pour la protection à tout prix. Il faut se souvenir que, quoi qu’on fasse, subsistera toujours un niveau d’incertitude, et un niveau de danger, et qu’ils doivent être pris en compte. L’attitude consistant à dire : faisons comme si tout était connu, et cherchons ensuite à réduire les incertitudes n’est pas bonne dans son principe. On s’attend, bien sûr, à ce que la position de quelque îlot dans le Pacifique ne soit pas connue avec une extrême précision. Mais on sait moins qu’il reste des endroits où les frontières de la France sont floues à 100 ou 200 mètres près. C’est le cas avec l’Italie, près du mont Blanc, et avec l’Espagne, près de l’enclave de Llivia (source : IGN). On voit ainsi, sur ce petit exemple, combien les données restent imprécises, même dans nos États modernes. Il en va de même sur la plupart des sujets : revenus, chômage, durée de vie, etc. On peut toujours, bien sûr, améliorer cette connaissance, mais le coût associé devient vite injustifié. C’est un élément très général, que les ingénieurs, toujours très cartésiens, comprennent mal et acceptent mal : une précision excessive est inutile. On pourrait passer du temps, consacrer de l’argent, à améliorer le tracé de nos frontières : descendre au mètre, voire au millimètre. Mais à quoi bon ?

La modélisation peut éclairer la prise de décision en univers incertain à condition de respecter une démarche progressive et rigoureuse

Dès qu’on touche à la prospective, l’ignorance des lois est la règle

Commençons par une remarque de bon sens : chaque jour, chacun de nous est amené à prendre des décisions, sans jamais avoir toute l’information disponible : choix d’un itinéraire, d’un restaurant, choix professionnels, etc. Nous y parvenons pourtant, souvent par comparaison avec des situations anciennes, souvent par élimination. Bien sûr, ces décisions ne sont pas » optimales « , mais elles sont prises en un temps généralement court. Autrement dit, le processus de décision ne résulte pas d’un algorithme d’optimisation, au sens académique du mot : l’intelligence humaine ne construit pas une » fonction objectif « , qu’elle cherche à optimiser sous certaines contraintes. Partant de cette remarque, nous avons cherché à améliorer les outils permettant la prise de décision en environnement incertain : c’est l’objet de notre programme de recherche » Robust Mathematical Modeling » (en collaboration avec une soixantaine d’institutions, entreprises, universités), auquel j’ai déjà fait allusion plus haut. Les règles de base sont assez simples :

- - on ne recherche pas un optimum précis (qui est dépourvu de sens), mais une solution acceptable obtenue rapidement (Quick Acceptable Solution, QAS). On abandonne donc complètement la recherche d’un optimum ; il n’y a plus que des contraintes. Par exemple : faire une tournée avec 3 % de camions en moins, par rapport à l’an dernier, ou 5 % de temps en moins, etc. Dès qu’une QAS est trouvée, on peut renforcer les contraintes, et si on ne trouve pas de QAS, on les relaxe ;

- - les contraintes elles-mêmes sont simplifiées, car il ne sert à rien de décrire une contrainte de manière fine dans un environnement incertain. On les suppose par exemple linéaires par morceaux ;

- - toutes les données, paramètres, lois, qui ne sont pas connus avec précision sont traités sous forme de lois de probabilité : loi uniforme, si on ne connaît que deux bornes, lois plus spécifiques si on dispose d’informations particulières.

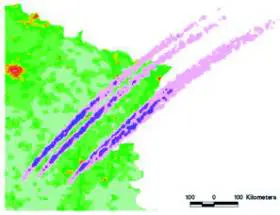

Le résultat est alors donné sous forme de » carte probabiliste « , et non plus de résultat précis. Voici un exemple : En 2004–2005, le CNES nous avait demandé d’étudier les risques associés à la chute des débris provenant de la désintégration de satellites. Il y a très peu de données et les lois sont mal connues. En particulier, dans la formule donnant la résistance de l’air, nous avons considéré que la densité de l’air, aux différentes altitudes, était probabiliste ; de même pour la forme du débris, sa masse, le coefficient de traînée, et même l’exposant de la vitesse : personne n’est sûr que la résistance soit proportionnelle au carré de la vitesse, pour des mobiles à 7 km/s en atmosphère raréfiée, à 100 km d’altitude. Le résultat n’a pas été un point de chute précis, mais une » carte probabiliste » : voici où les débris peuvent tomber, avec quelle probabilité.

La recherche mathématique, correspondant aux situations incertaines, n’en est qu’à ses balbutiements

Les incertitudes existent, et elles existent de manière fondamentale

Tout reste à inventer. Les difficultés sont scientifiques et techniques, mais surtout culturelles : les ingénieurs aiment calculer précisément, et les experts voudraient fonder une décision précise sur une connaissance précise. C’est pourquoi les décideurs, les politiques, se plaignent si souvent des rapports d’experts : ils leur reprochent de se réfugier derrière leurs incertitudes, leurs ignorances, pour ne pas prendre position. Ce reproche est légitime, et je crois que les scientifiques doivent l’assumer : nous devons fournir une aide à la décision, même en environnement incertain, car les décisions seront finalement prises, avec ou sans nous. C’est à nous de fournir des outils, même imparfaits, même grossiers, qui puissent éclairer ces décisions ; si nous ne le faisons pas, elles seront prises sans nous, et nous n’aurons pas le droit de nous en plaindre. À l’inverse, si nous éclairons le décideur, même de manière imparfaite, même de manière grossière, l’expérience prouve qu’il suit généralement les avis qui lui sont donnés. Nous portons alors pour partie la responsabilité des décisions qui sont prises, et c’est ce qu’il faut souhaiter.