L’avènement du multimédia

Le multimédia - qui utilise ou concerne plusieurs médias selon le Larousse – est-il une mode ou une évolution technologique majeure ?

« 23,3 millions de mots, 17 000 médias spectaculaires dont plus de 60 panoramiques 2D et 3D, plus de 200 vidéos et animations, plus de 11 500 photos, dessins, documents et tableaux de données, plus de 1 800 cartes géopolitiques et thématiques interactives, diagrammes, fiches pays, plus de 3 000 documents sonores. »

Cet extrait de la publicité de l’encyclopédie Hachette Multimédia présente ainsi les divers médias contenus sur un support unique : le CD-ROM. Tout est ou devient « multimédia » depuis le CD-ROM jusqu’à la télévision haute définition en passant par le téléphone mobile, la console de jeux, le PC et Internet. La plupart des journaux ont désormais un supplément multimédia. Je roule aussi en Citroën XM multimédia. Le mot fait incontestablement recette mais quelle est la raison de cet engouement ?

Du tout-analogique au tout-numérique

Le multimédia est souvent présenté comme le fruit de la convergence annoncée des technologies de l’informatique, des télécommunications et du monde des médias. L’histoire des techniques retiendra surtout qu’en cette fin de XXe siècle les informations manipulées par les médias sont passées en moins de trente ans d’une représentation « tout-analogique », propre à chaque média, au codage « tout-numérique ».

La règle à calcul analogique inventée en 1622 a été remplacée par la calculette numérique en 1975, le disque 33 tours analogique par le disque compact numérique en 1982. En juillet 1997, les images de la sonde martienne Pathfinder, prises et transmises par des systèmes numériques, ont été publiées directement par la NASA sur Internet. Des millions de personnes en ont pris connaissance sans aucun intermédiaire analogique dans toute la chaîne depuis Mars.

http://nssdc.gsfc.nasa.gov/planetary/image/marspath_ss24_1.jpg

En 1998, il s’est vendu, pour la première fois dans le Monde, plus de téléphones mobiles où le son est numérisé de bout en bout que de téléphones fixes analogiques. La télévision numérique, qui s’impose actuellement sur le câble et le satellite, a fait ses débuts en diffusion terrestre en novembre 1998 aux États-Unis. Les Américains visent un arrêt total des émissions analogiques en 2006. Avec l’appareil photo numérique grand public dont 180 000 exemplaires seront vendus en France en 1999, le dernier média analogique va disparaître.

Cette transformation radicale a été provoquée par les progrès dans les technologies des microprocesseurs, des mémoires, des systèmes de stockage, des logiciels et des télécommunications qui ont permis de construire des systèmes numériques de plus en plus puissants à des coûts raisonnables.

Des réseaux spécialisés à l’Internet

Les réseaux ont toujours été des sources de progrès et d’innovation comme les routes et les aqueducs de l’empire romain ou les chemins de fer du xixe siècle. Les réseaux téléphoniques, de télédiffusion ou de satellites du xxe siècle ont permis de nous affranchir des contraintes de l’espace et du temps. Ces réseaux construits pour optimiser la diffusion d’un média étaient de remarquables exploits d’ingénieurs.

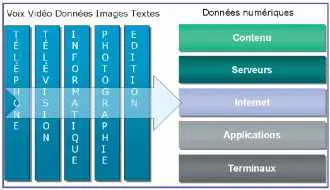

Cependant, le développement des technologies numériques est en train de changer complètement les règles du jeu. Les réseaux spécialisés, optimisés pour un seul média, sont remplacés par une infrastructure unique réduite à son rôle le plus élémentaire : la connectivité. Fondée sur les technologies de l’informatique et les standards de l’Internet, cette infrastructure permet maintenant de tout connecter à tout, partout. Cette infrastructure mondiale unique qui se met en place autour des réseaux de calculateurs reliés par l’Internet aura sans doute une plus grande influence sur notre société que celle de tous les réseaux précédents.

Cependant, le développement des technologies numériques est en train de changer complètement les règles du jeu. Les réseaux spécialisés, optimisés pour un seul média, sont remplacés par une infrastructure unique réduite à son rôle le plus élémentaire : la connectivité. Fondée sur les technologies de l’informatique et les standards de l’Internet, cette infrastructure permet maintenant de tout connecter à tout, partout. Cette infrastructure mondiale unique qui se met en place autour des réseaux de calculateurs reliés par l’Internet aura sans doute une plus grande influence sur notre société que celle de tous les réseaux précédents.

Autrefois, chaque média avait construit son infrastructure spécialisée. Pour fournir un service de téléphone, il fallait d’abord faire des investissements considérables dans un réseau dédié et dans des équipements terminaux. Pour développer la télévision, il avait été nécessaire de tout standardiser depuis les caméras jusqu’aux récepteurs de télévision. Ces deux réseaux avaient été en leur temps des réussites techniques exemplaires.

Cependant, l’interdépendance de tous les éléments rend les évolutions très difficiles et très lentes. Le passage du téléphone au numérique (Numéris) n’a concerné qu’une modeste part de marché (édition), les autres clients étant peu motivés car il était nécessaire de changer les équipements terminaux pour un avantage minime. L’évolution de la télévision vers la couleur ou le son stéréo a été lente et complexe pour rester compatible avec les équipements installés.

Par ailleurs, malgré la baisse du coût de certains équipements, l’évolution rapide de la technologie a obligé les opérateurs à mettre à niveau leur réseau ce qui a pu donner l’impression que les baisses de coût n’étaient pas répercutées au niveau des tarifs. En fait, l’intégration verticale permet aux fournisseurs de facturer un coût global incluant le coût de la communication et celui des services fournis.

Le remplacement des terminaux simples par des PC puissants a permis de déployer la technologie Internet. Internet réduit le réseau à sa fonction de base : assurer la connexion entre deux équipements. En revanche, il ne fournit aucun des services assurés traditionnellement par les opérateurs de télécommunications comme l’acheminement correct des informations ou une garantie de débit. Chaque élément d’un réseau Internet a le droit d’éliminer les informations qui circulent en cas d’incident ou de surcharge. Ce sont les logiciels des machines connectées qui font leur affaire de s’adapter au débit disponible, de renvoyer si nécessaire les informations perdues et bien sûr de s’adapter au type de contenu.

Cette simplification du réseau a un prix : il faut une puissance de calcul d’environ un million d’instructions par seconde à chaque extrémité. Il y a dix ans, seules les stations de travail haut de gamme supportaient cette pénalisation. Aujourd’hui, le PC bas de gamme exécute plusieurs centaines de millions d’instructions par seconde rendant ainsi économique l’usage de cette technologie.

L’infrastructure Internet change donc la donne. Elle permet d’éliminer les interdépendances en séparant l’infrastructure de communication et les applications qui l’utilisent. Il se crée ainsi deux marchés mondiaux très concurrentiels : celui qui fournit la connectivité mondiale et celui des contenus et des services.

Cette nouvelle concurrence a déjà permis de réduire le coût de la connectivité par un facteur de 1 à plusieurs milliers. Avec un accès par le câble ou l’ADSL, un particulier est connecté en permanence à grande vitesse sur Internet pour 300 francs par mois. Mais surtout, cette nouvelle infrastructure favorise l’innovation. Les nouvelles applications ou les nouveaux services peuvent bénéficier sans investissement réseau d’une connectivité mondiale vers bientôt un milliard de clients potentiels à un coût marginal.

Pour comprendre

Pour comprendre cette évolution et ses conséquences, il faut faire un peu d’histoire et un peu de technique.

Le calculateur tel que nous le connaissons naît vers 1950. C’est un très gros bébé : plusieurs dizaines de tonnes avec son usine électrique pour l’alimenter, lent avec sa centaine d’instructions par seconde et doté d’une toute petite cervelle de quelques milliers d’octets de mémoire. Le but : remplacer la célèbre table de logarithmes, encore en usage lorsque j’ai passé les concours des grandes écoles, pour faire des calculs numériques fastidieux. Cette naissance est déjà une demi-surprise.

Normalement, bien que des calculateurs spécialisés aient été enfantés par les équipes de R&D des fabricants de centraux téléphoniques comme les Bell Labs, le premier calculateur à programme enregistré en mémoire, tel que nous le connaissons aujourd’hui, a été réalisé à l’Université de Harvard.

En effet, ce sont les téléphonistes qui construisent les machines les plus complexes de l’époque : les centraux téléphoniques automatiques. Ils ont détrôné les grandes orgues qui ont été pendant deux siècles les machines avec le plus grand nombre de composants. Cependant la logique câblée reste la règle.

Le calculateur est né d’une idée fondamentale simple : réaliser une machine avec un nombre très réduit d’instructions, spécialisée uniquement par un « programme » chargé dans la mémoire comme des données. Or, pour chaque type d’application, de nombreux techniciens pensaient (et certains continuent de le croire) qu’une machine spécialisée serait moins chère et plus performante.

C’est pourtant le calculateur banalisé spécialisé par du logiciel qui a progressivement triomphé dans tous les domaines, ouvrant la voie, comme on le verra plus loin, au multimédia. Mais revenons aux débuts des années 50. Le marché mondial de tels « cerveaux électroniques » est alors évalué à environ 50 machines par une étude de marché qui est restée célèbre. Le vrai démarrage du calculateur, c’est d’abord l’invention du transistor avec une durée de vie quasi illimitée qui remplace les tubes électroniques peu fiables, puis du circuit intégré avec la fameuse loi de Moore (directeur chez Fairchild et ensuite fondateur d’Intel) qui prédit dès 1964 un doublement du nombre de transistors par circuits tous les dix-huit mois. Depuis trente-cinq ans, l’informatique vit avec cette croissance exponentielle qui n’a pas d’équivalent dans d’autres domaines.

Cette amélioration du rapport performance/prix d’environ 30 % par an explique l’introduction progressive du calculateur dans tous les équipements et activités humaines. Il faut noter que rien n’a changé depuis le début du calculateur si ce n’est la taille des composants et la vitesse d’exécution. On est passé de quelques milliers de positions mémoires à plusieurs centaines de millions et le nombre d’instructions exécutées par seconde va bientôt dépasser le milliard ! Le principe de base est resté le même : chaque tâche particulière est effectuée par l’exécution d’un « programme » suite d’instructions données à la machine.

Très rapidement, l’enjeu a été l’écriture de ces fameux programmes, les logiciels dont le mot est apparu au début des années 70. Les premiers programmes d’ordinateurs avaient été fabriqués par des mathématiciens et des scientifiques qui pensaient que le travail était simple et logique. Le logiciel s’est révélé plus difficile à développer qu’ils ne l’avaient supposé. Les ordinateurs étaient têtus. Ils s’obstinaient à faire ce qui était écrit plutôt que ce qui était voulu.

Une nouvelle race d’artisans prit le relais pour faire le travail et par un processus darwinien jeta progressivement les bases d’une nouvelle science. Une machine à tout faire, des spécialistes du logiciel, voilà les ingrédients de la recette gagnante.

La dialectique informatique – télécommunications

Au début des années 1970, le développement du téléphone et les premiers succès des calculateurs amènent les fabricants de centraux téléphoniques à remplacer la logique câblée par des calculateurs. Ils se lancent dans la construction de calculateurs spécialisés mieux adaptés, pensent-ils, aux tâches à réaliser. En effet, la fiabilité des calculateurs semblait insuffisante et certains pensaient trouver les instructions « miracle » qui allaient simplifier l’écriture et accélérer l’exécution des programmes. Construire des calculateurs était presque un jeu d’enfant pour ces spécialistes des logiques câblées très complexes.

En revanche, il fallait développer le logiciel qui allait avec, tâche autrement titanesque et systématiquement sous-estimée. La compétition avec les constructeurs de calculateurs « à tout faire » qui pouvaient amortir les dépenses de réalisation des logiciels sur de grandes séries tourne court. Au bout de quelques années, les industriels des télécommunications adoptent les calculateurs standard et leurs logiciels pour réaliser des systèmes de télécommunications.

La bataille des réseaux

Cette première « convergence » entre informatique et télécommunications donne naissance à la téléinformatique appelée en France « télématique ». L’idée de faire communiquer des calculateurs entre eux ou avec des terminaux à distance n’était pas nouvelle. Le coût des calculateurs était tel qu’il semblait obligatoire de le partager entre de nombreux utilisateurs : la prise de calcul à côté de la prise de courant. Ainsi sont nés les systèmes de « time sharing » à la fin des années 60.

Mais l’introduction du calculateur standard dans les réseaux favorise le développement des applications avec la création de Transpac en France, premier pays à être doté d’un réseau numérique national. Transpac servira de base à la mise en place de nombreuses applications professionnelles pour interconnecter des calculateurs comme la plupart des réseaux bancaires.

Dans le grand public, le réseau Télétel qui s’appuie sur Transpac et surtout le Minitel font une entrée remarquée. C’est la vogue des 3615… qui précède de dix ans celle des http://www… Mais le monde des réseaux reste un monde fractionné. Il y a un réseau téléphonique dont les extrémités sont analogiques, un réseau numérique pour les données, des réseaux analogiques de diffusion pour la radio et la télévision, un réseau radio numérique pour les téléphones mobiles, etc.

Le réseau unique apparaît comme une utopie d’informaticien. Chaque technologie raffine son réseau comme l’adjonction réussie des répondeurs, de la télécopie et des modems sur le réseau téléphonique ou les échecs successifs de la vidéo « à la demande » sur les réseaux câblés ou du D2MAC technologie hybride analogique-numérique sur les satellites.

Le réseau unique apparaît comme une utopie d’informaticien. Chaque technologie raffine son réseau comme l’adjonction réussie des répondeurs, de la télécopie et des modems sur le réseau téléphonique ou les échecs successifs de la vidéo « à la demande » sur les réseaux câblés ou du D2MAC technologie hybride analogique-numérique sur les satellites.

En fait, les partisans des réseaux spécialisés expliquent que pour tirer le meilleur parti d’une technologie et pour garantir le niveau de service, le débit ou les temps de réponse, il faut un réseau dit intelligent entièrement géré et maîtrisé autour du contenu. Les réseaux classiques et leurs interfaces sont conçus pour fonctionner dans des conditions de trafic fixes plutôt que pour s’adapter aux conditions réelles rencontrées. Cela conduit généralement à un surdimensionnement de la bande passante et de la puissance.

Un réseau comme Internet qui fournit le service minimum : la connectivité et qui ne garantit rien, même pas l’acheminement d’un paquet, semblait une idée aberrante. C’est pourtant ce qui s’est imposé et qui, en quelques années, a balayé toutes les objections des spécialistes. En fait, c’est ce service minimum qui permet aux programmes aux deux bouts de s’adapter au débit instantané constaté ou de redemander si nécessaire la réémission des paquets perdus. Il est bien évident que le protocole Internet ne supprime pas le métier d’opérateur de télécommunications qui doit fournir et optimiser des capacités de transport de plus en plus importantes.

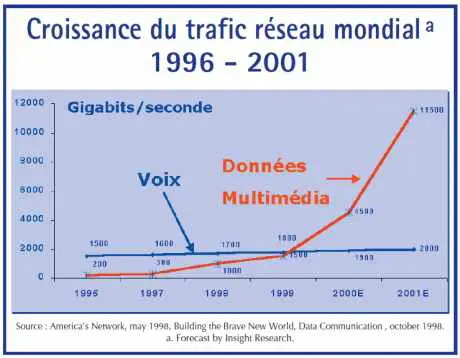

Cependant les services demandés à ce réseau se banalisent et c’est le même réseau qui transportera tous les types de données sous forme numérique. Le trafic téléphonique qui représentait il y a quelques années 90 % du trafic des réseaux va rapidement se dissoudre dans le trafic de l’Internet. Le trafic du backbone Internet de MCIWorlcom double tous les cent jours, soit une croissance de 1 000 % par an. AT&T a annoncé qu’il n’achèterait plus de nouveaux centraux téléphoniques après 1999.

Le passage au numérique

L’idée de traiter toutes les informations sous forme numérique n’était pas évidente. Au début des années 60, toutes les informations manipulées par les technologies étaient des informations analogiques : la règle à calcul, le téléphone, le disque 33 tours, l’appareil photo, la radio et la télévision.

L’avantage d’une représentation numérique pour faire des calculs sur les nombres était évident. Les algorithmes qui avaient conduit au succès de la numération de position au XVe siècle étaient faciles à transposer en programmes.

Le système de représentation en base 2 utilisé dans les calculateurs est proche de l’optimum en termes d’efficacité pour stocker des nombres. Le rapport nombre de chiffres/nombre est minimum pour une représentation en base e. Mais, il n’en était déjà plus de même pour les lettres : les premiers codes n’utilisaient que 5 à 6 bits seulement pour représenter un caractère. L’idée d’utiliser 8 bits soit 256 possibilités pour représenter un alphabet de 26 lettres et 10 chiffres semblait au début un gaspillage considérable. Aujourd’hui, on est passé à 16 bits par caractère avec l’Unicode, nécessaire sur Internet pour représenter simultanément tous les alphabets de toutes les langues y compris le chinois.

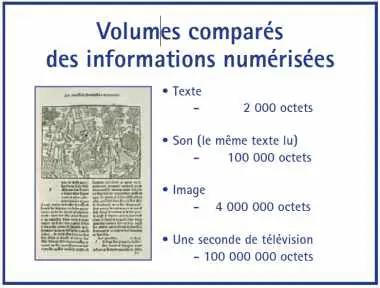

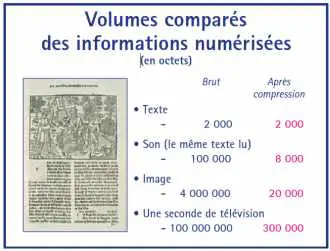

En revanche, la numérisation du son ou de l’image engendre un volume considérable d’informations. Une seconde de télévision numérique ou trois minutes de son sur un disque compact, c’est cent fois la Bible.

Pour traiter ces informations, souvent en temps réel, il fallait des vitesses de calcul telles qu’elles semblaient hors de portée des calculateurs généralistes. Pour chaque média, l’histoire s’est répétée. Pour traiter ces masses de données, les techniciens inventent des systèmes spécialisés. Le matériel construit en petite série coûte cher et le logiciel est très long à développer.

Dès que les calculateurs standard ont la puissance et la capacité mémoire suffisante, ils balayent tous ces développements spécifiques et ce sont les logiciels des informaticiens qui prennent le relais. Pour s’en convaincre, regardons ce qui se passe dans l’industrie du disque.

Du 33 tours au mp3

Le disque compact (CD) fait son apparition en 1983. C’est la première application grand public de la numérisation du son. Pour obtenir une bonne qualité, le son est échantillonné sur 16 bits à une fréquence de 44,1 kHz, ce qui nécessite pour un signal en stéréo un débit de 44 100 x 16 x 2 = 1.4 Mbit/seconde. Avec les informations de correction d’erreurs, il faut stocker 600 à 700 millions d’octets pour une heure de musique. Seul le disque optique numérique permet de stocker une telle quantité d’information sur un support aussi petit et peu coûteux. Malgré le coût élevé des équipements de gravure et de lecture, le CD a tout de suite été un grand succès et le disque analogique 33 tours en vinyle a disparu en quelques années.

Le disque compact (CD) fait son apparition en 1983. C’est la première application grand public de la numérisation du son. Pour obtenir une bonne qualité, le son est échantillonné sur 16 bits à une fréquence de 44,1 kHz, ce qui nécessite pour un signal en stéréo un débit de 44 100 x 16 x 2 = 1.4 Mbit/seconde. Avec les informations de correction d’erreurs, il faut stocker 600 à 700 millions d’octets pour une heure de musique. Seul le disque optique numérique permet de stocker une telle quantité d’information sur un support aussi petit et peu coûteux. Malgré le coût élevé des équipements de gravure et de lecture, le CD a tout de suite été un grand succès et le disque analogique 33 tours en vinyle a disparu en quelques années.

Le coût et la complexité des équipements spéciaux nécessaires pour fabriquer les CD semblaient protéger l’industrie du disque à tout jamais. En 1983, les microcalculateurs disposaient généralement de deux disquettes de 360 Ko comme moyen de stockage, soit l’équivalent de quelques secondes de musique. Mais la loi de Moore valable aussi pour le stockage sur disque a produit ses effets. Aujourd’hui, le PC standard dispose de disques de 6 à 10 Go qui permettent de stocker plus d’une dizaine de CD. Et le graveur de CD, au prix incroyablement bas de 1 190 F dans les promotions des supermarchés, permet de dupliquer un CD en quelques minutes sans perte de qualité sur un support qui est vendu 7 francs pièce.

Cependant, les ingénieurs ne se sont pas arrêtés là. Un morceau de musique numérique de quelques minutes, c’est 50 Mo de données. C’est beaucoup trop pour être transmis par réseau ou pour constituer une discothèque sur un PC. Une technologie de compression à débit ajustable développée à l’origine pour la télévision, le MPEG1 layer 3 dit « mp3 », s’est brusquement répandue sur le réseau Internet, au point de menacer l’industrie du disque traditionnelle. Avec des taux de compression de l’ordre de 10 à 20 sans perte audible de qualité sonore, le mp3 autorise la diffusion par Internet de musique de bonne qualité sans passer par les circuits traditionnels.

Les techniques de compression

Nous avons vu que la révolution multimédia s’appuie sur un calculateur standard très puissant, des informations numériques et un réseau de communication mondial unique. Le dernier ingrédient technique est l’indispensable compression des données. Il y a, en gros, deux sortes de techniques de compression. La compression qui conserve la totalité des informations initiales dite non destructive.

C’est celle qui est utilisée pour les programmes et les données dans les calculateurs : les fameux fichiers dit « zippés » qui permettent lors de la décompression de restituer le fichier exactement dans l’état initial. Les performances couramment observées sont des réductions de taille de l’ordre de 4. Insuffisant pour le son, les images ou la télévision. Pour que la numérisation soit économiquement acceptable, les données numériques doivent se contenter de la bande passante nécessaire pour les anciens signaux analogiques. Les taux de compression à atteindre sont donc de 10 à 1 000.

C’est celle qui est utilisée pour les programmes et les données dans les calculateurs : les fameux fichiers dit « zippés » qui permettent lors de la décompression de restituer le fichier exactement dans l’état initial. Les performances couramment observées sont des réductions de taille de l’ordre de 4. Insuffisant pour le son, les images ou la télévision. Pour que la numérisation soit économiquement acceptable, les données numériques doivent se contenter de la bande passante nécessaire pour les anciens signaux analogiques. Les taux de compression à atteindre sont donc de 10 à 1 000.

Pour y arriver, il faut diminuer le nombre d’informations transmises. On utilise les caractéristiques physiques de l’œil et de l’oreille humaine. Le signal compressé perd les détails qui ne sont pas perçus. Pour donner des ordres de grandeurs, on obtient des taux de compression sans dégradation notable par l’oreille ou par l’œil de 10 à 20 pour le son, de 20 à 50 pour les images, de 100 à 200 pour la télévision.

La décompression est une opération relativement rapide. En revanche, la compression nécessite une très grande puissance de calcul, surtout pour des signaux comprimés en temps réel comme pour le téléphone ou la télévision en direct. Au fur et à mesure de l’amélioration des performances des calculateurs standard, les techniques logicielles prennent progressivement le relais des équipements spécialisés.

Les empires du multimédia s’organisent autour des contenus

La révolution multimédia bouscule les acteurs en place. À la lumière de ces évolutions techniques, il est facile de prévoir que la maîtrise de l’infrastructure Internet et la maîtrise des contenus seront les enjeux de la prochaine décennie.

L’importance d’Internet

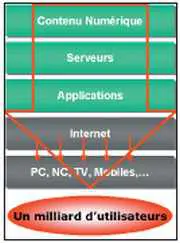

Internet, ou plus précisément l’infrastructure IP, représente une frontière clé entre un média de communication et les applications construites sur ce média. C’est une frontière très spéciale, puisqu’elle permet à ces deux marchés de fonctionner selon leurs propres règles. Avec les nouvelles technologies numériques, l’avantage s’est déplacé vers une conception souple qui permet de tirer parti d’opportunités non prévues.

Internet, ou plus précisément l’infrastructure IP, représente une frontière clé entre un média de communication et les applications construites sur ce média. C’est une frontière très spéciale, puisqu’elle permet à ces deux marchés de fonctionner selon leurs propres règles. Avec les nouvelles technologies numériques, l’avantage s’est déplacé vers une conception souple qui permet de tirer parti d’opportunités non prévues.

En évitant les biais des réseaux précédents optimisés autour d’un contenu, l’infrastructure IP a créé une place de marché pour des concepts nouveaux qui tirent parti de la connectivité abondante et peu coûteuse. Dans ce domaine, les enjeux seront de fournir une connectivité permanente à des équipements fixes ou mobiles avec le meilleur rapport performance/prix.

Cependant, la banalisation de l’infrastructure et des composants techniques n’entraînera ni le terminal unique, ni la fusion des différents métiers des médias. L’idée d’un terminal unique à tout faire (PC, télévision, téléphone, fax…) est une utopie d’auteur de science-fiction. La technologie va disparaître sous la fonction et nous allons, bien au contraire, assister à l’apparition de nombreux terminaux spécialisés par fonction et faciles à utiliser.

L’importance du contenu

L’ensemble des contenus numérisés va être diffusé à partir de serveurs au travers d’applications. De même que pour les équipements, la convergence vers une technologie unique ne va pas entraîner de fusion des métiers. Les métiers de l’informatique, de l’édition ou de la télévision vont rester séparés. En revanche, la manière d’exercer ces métiers va profondément changer et la possession des contenus deviendra un des enjeux prioritaires.

Et demain

La loi de Moore va continuer de s’appliquer pendant encore dix ans avant d’atteindre la limite physique de la taille des transistors sur les circuits intégrés. Avec un doublement tous les dix-huit mois, il reste donc encore à gagner un rapport 1 000.

L’amélioration des performances des fibres optiques dont la capacité double tous les ans est encore plus spectaculaire. Ces meilleures performances vont surtout permettre de fournir des interfaces plus naturelles avec les machines en ajoutant aux écrans, claviers, souris, la reconnaissance de la voix et de l’écriture manuscrite. Bien que le calculateur soit banalisé, il existe encore des périphériques spécialisés qu’il faut connecter au calculateur : la carte son, la carte vidéo, la carte Tuner FM ou TV ou le téléphone mobile avec son Modem.

Les interfaces (bus) nécessaires pour connecter ces cartes compliquent les calculateurs. Au fur et à mesure de l’augmentation de la puissance, ces cartes seront aussi remplacées par des logiciels. C’est en cours pour le son ou la vidéo. Demain un récepteur radio ou un téléphone mobile seront obtenus à partir d’un calculateur standard. La partie radio échantillonnera l’ensemble d’une gamme de fréquences directement en mémoire RAM et le calculateur standard se transformera en récepteur radio ou en téléphone mobile par une simple mise à jour de logiciel.

Vers le milliard d’utilisateurs connectés

L’augmentation régulière de la puissance des microprocesseurs, les progrès du logiciel, le multimédia et l’Internet dessinent les contours d’un nouveau paysage : la société de l’information. Dans quelques années, un milliard d’utilisateurs et une quantité innombrable de terminaux, capteurs, équipements seront interconnectés pour acheter, vendre et échanger librement des informations ou des services.

Ces nouvelles technologies de l’information représentent un bouleversement culturel des modes d’éducation et de communication qui va changer le fonctionnement même de la société, modifiant par exemple l’organisation du travail, l’accès des citoyens aux services de santé ou d’éducation, les relations administration/administré, voire les conditions d’exercice de la démocratie.

L’odyssée informatique vient tout juste de commencer.