La transformation des métiers de la santé

Les algorithmes d’intelligence artificielle cherchent maintenant à exploiter l’immensité des dossiers médicaux pour essayer d’assurer une bonne prévention ou prescrire un traitement personnalisé. Pour de multiples raisons les résultats obtenus sont mitigés, on arrive à égaler l’expert, mais pas encore à le surpasser.

En dépit de toutes les données dont on dispose, le choix d’un traitement contre un cancer (chirurgie, chimiothérapie, thérapie ciblée…) s’effectue, à quelques exceptions près, comme il y a quinze ans, à partir d’un nombre limité de paramètres comme l’âge du patient, la taille et l’aspect au microscope de la tumeur, la présence ou non de métastases, ou l’expression de deux ou trois protéines connues.

REPÈRES

Le génome humain a été décrypté il y a quinze ans, et les médecins disposent maintenant de technologies permettant de caractériser au niveau moléculaire chaque patient, par exemple en identifiant la liste exhaustive des milliers de mutations dans son ADN ou celle de sa tumeur.

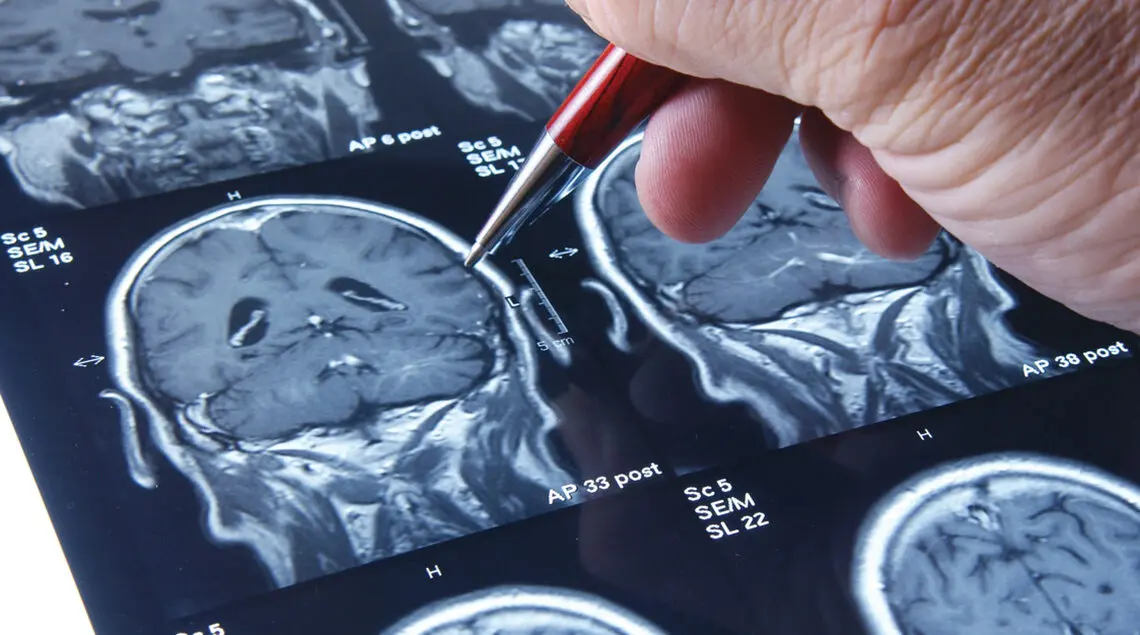

Les techniques d’imagerie ont également beaucoup progressé depuis quinze ans, et les médecins ont par ailleurs accès à l’ensemble du dossier médical de chaque patient sous forme électronique, notamment les diverses analyses biologiques, radiographies, échographies, IRM, etc.

Mises bout à bout, ces données représentent facilement des téraoctets de données par patient.

ASSISTER L’EXPERTISE HUMAINE

On peut légitimement se demander si une meilleure exploitation des données de santé, couplée à des algorithmes d’intelligence artificielle, pourrait améliorer la pratique médicale, par exemple pour identifier le traitement le plus efficace pour chaque patient, éviter des traitements inutiles ou néfastes, voire pour proposer des approches thérapeutiques complètement nouvelles.

La réponse à cette question est certainement positive, au moins pour certaines applications de l’intelligence artificielle visant à automatiser ou imiter certaines tâches faites actuellement par des experts humains ; elle me semble moins évidente, au moins sur le court et moyen terme, pour ce qui concerne le dépassement de l’expertise humaine.

MIEUX INTERPRÉTER LES CLICHÉS MÉDICAUX

Le premier type d’applications comprend des tâches visant à « imiter » l’expertise humaine.

L’IA peut aider les médecins à interpréter des clichés. © FOTOGRAFICHE.EU

Par exemple, quand il s’agit de détecter une tumeur sur une mammographie ou de décider si un grain de beauté pris en photo par un smartphone est potentiellement un mélanome.

Ces tâches sont effectuées aujourd’hui par des humains, généralement experts et entraînés pendant de longues années. Il est difficile d’automatiser ces tâches avec des algorithmes basés sur des règles fixes, car il est difficile de coder explicitement comment l’expert prend sa décision.

Mais il est facile de collecter de grandes quantités de données annotées par ces experts, ce qui ouvre la voie à l’utilisation de techniques d’apprentissage supervisée pour laisser le programme « apprendre » à imiter l’expert.

UNE AIDE AU DIAGNOSTIC

De telles applications peuvent avoir un impact important et rapide sur la pratique médicale. Elles fournissent un référentiel consistant, utilisable dans de nombreux hôpitaux, notamment aux endroits ne disposant pas des meilleurs experts. Elles peuvent démocratiser et faciliter l’accès à certains examens, comme l’analyse rapide d’images prises par un smartphone, afin de faire entrer dans le système de soins des patients à un stade plus précoce de la maladie, et donc plus facile à traiter.

Elles peuvent aussi décharger les experts de certaines tâches répétitives afin qu’ils puissent se concentrer sur les tâches à plus forte valeur ajoutée, comme l’analyse plus fine des images ou des dossiers identifiés à risque par un algorithme automatique.

IMITER OU DÉPASSER L’EXPERT

Plutôt qu’imiter un expert, un système informatique peut-il le dépasser et, par exemple, faire des diagnostics plus précis que les humains ou suggérer de nouvelles approches thérapeutiques ?

PRÉDICTIONS PAR ALGORITHME

Des équipes de l’université Stanford ont entraîné un réseau de neurones pour reconnaître des cancers potentiels à partir d’images de la peau, en entraînant le modèle sur 130 000 images annotées par des experts.

Dans une étude publiée en 2017 dans la revue Nature, elles ont montré qu’après entraînement les prédictions de l’algorithme étaient aussi précises que celles de dermatologistes professionnels.

Cette vision séduisante, largement véhiculée par les médias, fait l’objet d’intenses efforts de recherche et d’investissement de la part du monde académique et industriel. Dans le langage de l’intelligence artificielle, la différence entre « imiter l’expert » et « dépasser l’expert » n’est pas très importante et s’appuie sur les mêmes concepts et outils algorithmiques.

“ La révolution génomique des années 2000 n’a pas encore révolutionné le traitement des cancers ”

En effet, pour imiter l’expert, un système d’apprentissage automatique sera entraîné de manière supervisée avec des données pour lui apprendre le lien entre des mesures (par exemple, un dossier médical) et une décision prise par un expert (par exemple, identifier une tumeur).

Pour dépasser l’expert, il suffit d’entraîner le même système non pas avec les décisions de l’expert, mais par exemple avec l’évolution observée de la maladie suite à un traitement.

DES RÉSULTATS PARFOIS EN DEÇÀ DES ESPOIRS

Malgré sa simplicité conceptuelle, la tâche peut cependant se révéler ardue, et les résultats tardent encore à se concrétiser dans la pratique médicale. Prenons l’exemple du choix thérapeutique dans le cancer du sein.

Collecter des millions de paramètres ne suffit pas à révolutionner les pratiques. © SEPY

Depuis une quinzaine d’années, plusieurs études ont collecté des grandes quantités de données génomiques sur des cohortes de patients atteints de cancer, afin d’identifier des modèles prédictifs de risque de récidive ou de réponse aux traitements par apprentissage statistique.

Certaines études ont d’ailleurs abouti à des modèles prédictifs commercialisés, basant leur prédiction sur l’analyse de quelques dizaines de gènes identifiés par des procédures automatiques.

Mais leur performance est au plus marginalement supérieure aux approches standard, pour un coût bien supérieur ; la révolution génomique des années 2000 n’a pas encore révolutionné le traitement des cancers, malgré les quantités phénoménales de données collectées.

Il semble donc qu’il ne suffise pas de collecter des millions de paramètres a priori intéressants et d’entraîner des modèles d’apprentissage automatique pour révolutionner une pratique qui peut sembler bien naïve, mais reste largement utilisée dans les hôpitaux.

BIG DATA VS DIRTY DATA

Pourquoi de telles approches, consistant à collecter des grandes quantités de données et à entraîner des modèles (parfois complexes), n’améliorent-elles pas toujours des approches standard souvent basées sur un petit nombre de paramètres ? On peut avancer plusieurs raisons. Tout d’abord se pose la question de la qualité des données : il peut arriver que big data soit souvent lié à dirty data, et que le bruit des données cache le signal intéressant.

“ Le moteur de l’intelligence artificielle est de parvenir à collecter de grandes quantités de données sur beaucoup d’individus ”

Les progrès technologiques et la standardisation des protocoles peuvent résoudre en partie cette question, même si les données comme les comptes rendus d’examens médicaux rédigés en texte libre par des médecins restent redoutablement difficiles à standardiser.

Deuxièmement, il se peut que, même sans bruit, les données mesurées ne contiennent pas l’information pertinente pour résoudre le problème identifié. Par exemple, il se peut que le niveau d’expression des 20 000 gènes codés par notre génome ne contienne pas plus d’information que quatre ou cinq paramètres cliniques standard pour prédire le risque d’une récidive du cancer.

CROISER LES APPROCHES

Pour pallier ce problème, une solution semble alors de collecter des données différentes, par exemple de compléter l’expression des gènes par les mutations de l’ADN, les images d’IRM, l’ensemble du dossier médical, etc., en espérant qu’en combinant plus de données, on augmente l’information qu’elles contiennent pour le problème de prédiction que l’on cherche à résoudre.

Cependant, cette tendance se heurte frontalement à une troisième raison qui peut expliquer la faible performance des modèles prédictifs : le fait que pour entraîner des modèles prédictifs performants par apprentissage automatique, il faut beaucoup d’exemples, dans notre cas beaucoup de patients ; et plus on mesure de paramètres différents, plus il faut d’exemples, pour des raisons purement mathématiques et statistiques.

Il se peut que le niveau d’expression des 20 000 gènes codés par notre génome ne contienne pas plus d’information que quatre ou cinq paramètres cliniques standard pour prédire le risque d’une récidive du cancer.

© VITSTUDIO

Cela pose la question de développer la théorie et les algorithmes pour l’apprentissage automatique de modèles complexes à partir de relativement peu de données, question passionnante mais difficile.

DES QUESTIONS ÉTHIQUES ET LÉGALES

Le moteur de l’intelligence artificielle étant de parvenir à collecter de grandes quantités de données sur beaucoup d’individus, le domaine de la santé soulève des questions spécifiques à ce sujet. En plus de la difficulté fondamentale de réunir des cohortes de patients de taille suffisante, les questions éthiques et légales autour de la manipulation des données de santé sont nombreuses.

Qui possède les données ? Qui peut les utiliser ? À quelles fins ? À qui appartiendront les résultats ? Autant de questions au cœur de nombreuses discussions actuellement entre les différents acteurs, notamment la société civile et les associations de patients, le législateur, le corps médical et les entreprises.

Ces débats dépassent le côté purement technique de savoir si, grâce à ces données, un ordinateur aura un jour la capacité de mieux traiter un malade qu’un médecin aujourd’hui.