L’apprentissage profond entre mythes et réalités

Le deep learning, dont l’histoire est née il y a 70 ans et qui a fait un bond en avant avec les réseaux de neurones multicouches, n’est pas une boîte noire qui pourrait nous échapper. Il ne faut pas surestimer ses capacités même si les progrès qu’il a permis sont réels. Porté par la mode il n’est pas toujours la réponse la plus adaptée aux problématiques.

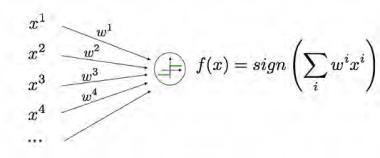

L’histoire du deep learning commence à la fin des années 1950 où naît l’idée d’un neurone élémentaire. Appelé alors perceptron, il a été conçu comme une machine physique, visant à la reconnaissance de formes 2D, et non pas comme un simple algorithme.

L’idée d’utiliser des successions de neurones s’est développée dans les années 80. Le problème crucial de ces réseaux multicouches est l’optimisation de leurs paramètres.

“ L’histoire du deep learning commence à la fin des années 50 ”

Il explique en partie le temps qu’il a fallu pour qu’ils s’imposent dans la communauté scientifique comme un outil important, malgré les succès que les réseaux multicouches avaient rencontrés dès les années 90, par exemple dans la reconnaissance de caractères ou la détection de visages.

Cette optimisation est en effet celle d’un problème non convexe de très grande dimension face auquel l’approche la plus performante reste l’application d’un simple algorithme de gradient stochastique qui permet simplement d’atteindre un optimum local.

La succession de nombreuses opérations complique aussi l’optimisation, qui a été pendant longtemps très laborieuse, et reste aujourd’hui relativement artisanale, malgré des avancées certaines.

REPÈRES

L’apprentissage paramétrique vise à résoudre une tâche en apprenant les paramètres d’une fonction de prédiction.

L’idée du deep learning (apprentissage profond en français) est d’exprimer cette fonction de prédiction comme une succession de fonctions élémentaires, tous les paramètres étant appris simultanément, mais en général sans garantie de convergence vers un optimum global.

En vision artificielle, les opérations élémentaires sont essentiellement des convolutions qui alternent avec des non-linéarités sans paramètres appris.

DES PROGRÈS À RELATIVISER

On insiste souvent sur les progrès que le deep learning a permis en termes de performance en vision artificielle et plus généralement en intelligence artificielle. Je pense que ceux-ci sont à relativiser par rapport à d’autres de ses conséquences.

“ Le deep learning n’est pas une boîte noire qui pourrait nous échapper comme certains le craignent ”

La première d’entre elles a été de susciter une attention très forte à la fois chez le grand public et les industriels. Cette attention a provoqué une croissance très forte à de nombreux niveaux. Certains d’entre eux posent d’ailleurs problème.

La taille des communautés scientifiques de l’apprentissage automatique et de la vision artificielle a, par exemple, augmenté exponentiellement ces dernières années, posant des problèmes d’évaluation des travaux (peer review).

UNE OCCASION À NE PAS MANQUER

La redécouverte du deep learning a aussi provoqué chez nombre d’entreprises et dans un certain nombre de domaines de recherche une peur de manquer un tournant stratégique, et renouvelé l’intérêt pour l’apprentissage artificiel et l’utilisation des données qu’elles peuvent collecter.

Réseau neuronal du cerveau, nœuds nerveux, rendu 3D

© USTAS

L’apprentissage profond n’est d’ailleurs pas toujours la réponse la plus adaptée à leurs problématiques. Cependant, même si c’est parfois une erreur de penser que le deep learning est la technologie qu’elles recherchent, je pense que leur intérêt pour l’exploitation de leurs données et les recrutements qu’elles opèrent dans ce but leur procureront une véritable plus-value.

L’intérêt des entreprises et des pouvoirs publics a aussi des conséquences pratiques pour la recherche, en encourageant et en permettant des projets communs. Les grosses entreprises qui souhaitent recruter les étudiants en thèse leur proposent des stages très attractifs, y compris sur des sujets fondamentaux.

Un de mes étudiants est en stage chez Adobe pour travailler sur de nouvelles manières de représenter abstraitement des scènes tridimensionnelles.

Les start-up sont aussi très demandeuses de collaboration avec des laboratoires académiques : je viens de commencer un projet avec Deepomatic sur l’apprentissage profond à partir de faibles quantités de données.

DES PEURS INFONDÉES

Certains craignent que le deep learning crée des machines intelligentes, potentiellement dangereuses pour les humains.

Neurone artificiel.

Mais je ne vois pas de raison pour que le deep learning soit un pas décisif vers le développement rapide d’une intelligence artificielle générale, qui entre en compétition avec l’humain.

L’entraînement d’un réseau de neurones ne diffère pas fondamentalement de celui de n’importe quel autre algorithme d’apprentissage supervisé : on optimise un certain nombre de paramètres pour minimiser un coût qui correspond à une mesure d’efficacité sur une tâche très particulière.

Si de nombreux chercheurs en intelligence artificielle parlent de « neurones » de « curiosité » ou d’« attention », c’est simplement par métaphore, et la réalité des algorithmes reste éloignée des analogies biologiques.

UNE MACHINERIE COMPLEXE ET MAÎTRISABLE

Pour conclure, le deep learning n’est pas une boîte noire qui pourrait nous échapper comme certains le craignent.

UN FORT ENGOUEMENT

L’intérêt des étudiants a également augmenté très fortement, faisant pression sur les masters existants et poussant à la création rapide d’autres formations.

À titre d’illustration, environ 120 polytechniciens sur une promotion de 500 ont demandé cette année à suivre le principal master parisien dans le domaine (master MVA, pour mathématiques, vision, apprentissage, cohabilité par plusieurs établissements dont l’ENS Paris-Saclay, Polytechnique et l’École des ponts) pendant leur 4e année.

Et les entreprises, qui recrutent activement à des salaires et dans des conditions très attractives des experts en apprentissage artificiel, rendent difficiles les recrutements sur ces thèmes dans le monde académique.

S’il est vrai qu’il s’agit d’une machinerie complexe, composée de nombreuses opérations élémentaires, aucune de ces opérations n’est difficile à comprendre, et la recherche a beaucoup progressé ces dernières années pour comprendre les processus en jeu dans l’ensemble d’un réseau de neurones, que ce soit de manière visuelle, intuitive, quantitative ou mathématique.

Cependant, il me semble que l’omniprésence de machines complexes et de plus en plus perfectionnées dans notre vie quotidienne va nous pousser à leur prêter cette conscience, voire à créer avec elles des relations affectives ou du moins des dépendances.

Elles vont aussi continuer d’influer sur notre manière de penser, en nous encourageant à nous reposer sur elles pour certains types de processus cognitifs.

Une réflexion éthique sur leur contrôle et leur place est donc bien sûr essentielle.