Le jeu vidéo : de l’artisanat à l’industrie

Les jeux aux États-Unis

Les jeux aux États-Unis

La préhistoire du jeu vidéo commence vraisemblablement au Massachussets Institute of Technology en 1961. Là, sur un des premiers ordinateurs DEC, « Slug » Russel, un étudiant en intelligence artificielle, développa Spacewar, un fabuleux programme dans lequel deux vaisseaux spatiaux soumis à l’attraction d’une planète s’affrontent au rayon laser. L’équipe de hackers du MIT, fascinée par ce jeu, trouvait les contrôles du jeu peu pratiques (il s’agissait d’interrupteurs sur un pupitre) et inventa le premier joystick.

Les bases du jeu vidéo moderne étaient dès lors posées : une interface homme machine évoluée constituée d’un joystick et d’un écran graphique, mais surtout une nouvelle approche de l’informatique. En rupture avec l’informatique traditionnelle dont le principe est de prendre des données en entrée, de faire un calcul, et de produire des données en sortie, le jeu vidéo ne produit rien ! Ce qui compte dans le jeu vidéo, ce n’est pas ce qu’on obtient à la fin, mais ce qui se passe pendant le fonctionnement. Du point de vue informatique, le jeu vidéo est un « effet de bord », terme hautement péjoratif pour un esprit scientifique normalement constitué.

Dix ans plus tard, en 1971, Nolan Bushnell fonde une société qui allait devenir un mythe dans les années 80, Atari, et produit le premier jeu d’arcade, Pong. Ce premier jeu allait populariser le jeu vidéo en le rendant accessible à tous, mais il fallut attendre l’apparition des micro-ordinateurs quelques années plus tard pour démocratiser sa réalisation. L’Apple II notamment, créé en 1976 et promis à une brillante carrière, permit l’émergence d’une nouvelle tribu, celle des auteurs de jeu. Avec un investissement minimal, et beaucoup de temps, et beaucoup de nuits blanches, il devenait possible pour n’importe qui de développer un jeu. La diffusion était plus difficile, mais un nombre de pièces modeste suffisait à rentabiliser un si faible investissement.

Les success-stories ne manquent pas : en 1980, Ken William, un informaticien américain, plaça toutes ses économies dans un Apple II dans le but de développer et de vendre un compilateur Fortran. Il n’en vendit pas un seul, mais sa femme, Roberta Williams, au début imperméable au charme de la machine, eut l’idée géniale de réaliser un jeu d’aventure appelé Mystery House et gagna 60 000 $ en trois mois. Encouragée par ce début, elle réalisa Wizard and the Princess et en vendit 60 000 copies, chiffre tout à fait extraordinaire à cette époque, et encore honorable aujourd’hui. Le couple fonda alors Sierra-Online et développa notamment la célèbre série des King Quest.

Les success-stories ne manquent pas : en 1980, Ken William, un informaticien américain, plaça toutes ses économies dans un Apple II dans le but de développer et de vendre un compilateur Fortran. Il n’en vendit pas un seul, mais sa femme, Roberta Williams, au début imperméable au charme de la machine, eut l’idée géniale de réaliser un jeu d’aventure appelé Mystery House et gagna 60 000 $ en trois mois. Encouragée par ce début, elle réalisa Wizard and the Princess et en vendit 60 000 copies, chiffre tout à fait extraordinaire à cette époque, et encore honorable aujourd’hui. Le couple fonda alors Sierra-Online et développa notamment la célèbre série des King Quest.

Les jeux en France

En France, les choses commencèrent au début des années 80. Un musicien chanteur compositeur inconnu en pleine galère, Philippe Ulrich, découvrit un ZX80 dans une galerie des Champs-Élysées, y plaça jusqu’à son dernier centime et fonda peu après avec des amis Ere Informatique, un éditeur qui allait connaître une renommée mondiale, grâce notamment à l’un de ses jeunes auteurs, Rémi Herbulot, ci-devant contrôleur de gestion.

À la même époque, un jeune chimiste lyonnais de 25 ans, Bruno Bonnel, profitant de l’initiative nationale de Thomson, fonda Infogrames, qui allait devenir une des sociétés les plus agressives du secteur. À Montreuil, c’est une famille d’entrepreneurs dans le matériel agricole qui créa Ubi-Soft. On reste interloqué devant une liste aussi éclectique de profils embarqués un peu par hasard dans la même aventure, et dominant encore aujourd’hui le secteur français du jeu vidéo. C’est peut-être ce qui permit un tel dynamisme.

Une nouvelle profession

Dès le début des années 80, un clivage s’installa dans la profession naissante entre auteurs et salariés. L’auteur réalisait souvent seul un logiciel complet puis allait sonner chez les différents éditeurs dans l’espoir d’être publié. Ce schéma évolua à partir du milieu des années 80 vers un système où l’auteur n’était plus seul mais devenait une petite équipe composée d’un programmeur, d’un ou deux graphistes et d’un musicien, et où l’éditeur consentait une avance sur droit d’auteur pour financer le développement qui devenait de plus en plus long : de quelques semaines au début, on passait à quelques trimestres. Le modèle auteur était notamment celui d’Ere Informatique, et apporta, à défaut de rentabilité, la gamme de logiciels la plus originale de la décennie. Aux États-Unis et en France chez Infogrames par exemple, le développement était le plus souvent interne et s’appuyait sur des licences, et c’est ainsi que la société de Bruno Bonnel fit main basse sur la plupart des licences européennes et sortit Astérix, les Schtroumpfs, Iznogoud, et même… Bob Morane.

Les développeurs de cette époque avaient rarement un bagage scientifique et avaient appris l’informatique chez eux, sur un simple micro-ordinateur. Pourtant, ce sont eux qui repoussèrent le plus loin les limites de leurs formidables machines. En fait, ces machines étaient incapables de faire ce que faisaient celles des « professionnels » ou des chercheurs : absence de système d’exploitation digne de ce nom, choix médiocre de langages de programmation (tout se faisait en assembleur ou en basic), mémoire de masse sous-développée toujours limitée à la disquette voire à la cassette audio. Au contraire, ces machines avaient des capacités toujours plus extraordinaires en termes de graphisme et de son, domaines encore peu explorés et peu scientifiques : peu d’algorithmes furent produits, mais beaucoup d’idées esthétiques ou interactives.

Les développeurs de cette époque avaient rarement un bagage scientifique et avaient appris l’informatique chez eux, sur un simple micro-ordinateur. Pourtant, ce sont eux qui repoussèrent le plus loin les limites de leurs formidables machines. En fait, ces machines étaient incapables de faire ce que faisaient celles des « professionnels » ou des chercheurs : absence de système d’exploitation digne de ce nom, choix médiocre de langages de programmation (tout se faisait en assembleur ou en basic), mémoire de masse sous-développée toujours limitée à la disquette voire à la cassette audio. Au contraire, ces machines avaient des capacités toujours plus extraordinaires en termes de graphisme et de son, domaines encore peu explorés et peu scientifiques : peu d’algorithmes furent produits, mais beaucoup d’idées esthétiques ou interactives.

L’arrivée des CD-ROM

Au début des années 90 apparut un nouveau support, le CD-ROM. Celui-ci allait révolutionner l’industrie et ses modes de fonctionnement. Jusqu’alors, les jeux étaient fournis sur disquette, support permettant de stocker peu de données. Il n’était pas rare de trouver dans les boîtes entre 10 et 20 disquettes pour un seul jeu, or un CD-ROM a la capacité d’environ 400 disquettes. Cette augmentation de la capacité de stockage provoqua une vraie révolution, car elle permit l’émergence d’une activité graphique importante. Il faut savoir qu’une disquette peut contenir environ 10 images de bonne qualité, et donc que le CD peut en contenir environ 4 000. Les premiers jeux sur CD-ROM furent donc principalement des jeux d’aventure regorgeant d’images et de musiques (The Seventh Guest, Dune…).

Ces images peuvent être de trois natures différentes : dessin, photo, image de synthèse 3D. Le dessin sur ordinateur est quelque chose de très long et qui se prête mal aux corrections et modifications en cours de projet. La photo se rapproche du travail cinématographique : il faut des comédiens, des décors, de l’éclairage, des effets spéciaux, toutes choses particulièrement coûteuses. L’image de synthèse 3D se trouve un peu entre les deux : le travail dit de modélisation est relativement long et fastidieux, il consiste à créer un espace fait de formes géométriques (triangles, sphères…) sur lesquelles on applique des images qui donnent une texture à ces formes (métal, bois…).

Ce travail ne nécessite qu’un matériel banal, accessible à tous. Une fois la modélisation effectuée, il est possible de prendre une « photo » depuis n’importe quel point de la scène. Ceci peut prendre beaucoup de temps machine car il y a beaucoup de calculs à effectuer, mais ne nécessite pas la présence physique d’un opérateur.

La synthèse 3D et ses conséquences

C’est donc cette dernière technique d’image de synthèse 3D, dite « 3D précalculée » qui eut le vent en poupe au début des années 90. Elle bouleversa la structure des maisons de développement. Les équipes enflèrent : de un programmeur, un musicien, un graphiste dans les années 80, on passa à un programmeur, un musicien, un scénariste et dix graphistes. Cette augmentation et ce changement d’équilibre eurent des impacts financiers et sociaux. Le budget de développement passa de 1 MF à 15 MF aujourd’hui. Le temps de production passa de un à deux ans, voire trois pour les projets difficiles.

C’est donc cette dernière technique d’image de synthèse 3D, dite « 3D précalculée » qui eut le vent en poupe au début des années 90. Elle bouleversa la structure des maisons de développement. Les équipes enflèrent : de un programmeur, un musicien, un graphiste dans les années 80, on passa à un programmeur, un musicien, un scénariste et dix graphistes. Cette augmentation et ce changement d’équilibre eurent des impacts financiers et sociaux. Le budget de développement passa de 1 MF à 15 MF aujourd’hui. Le temps de production passa de un à deux ans, voire trois pour les projets difficiles.

Un nouveau poste apparut, particulièrement rude, celui de chef de projet, dont le rôle est de faire travailler ensemble des profils très différents, dont le seul point commun est la jeunesse : c’est souvent leur premier emploi, et ils doivent donc apprendre la vie en entreprise. Le respect des délais est une difficulté que connaissent tous les éditeurs de jeux ; étant donné les sommes investies, l’éditeur laisse peu de marge entre la finalisation théorique du produit et sa mise en vente ; les difficultés techniques sont difficilement planifiables car ce sont des œuvres uniques, et il n’y a donc pas d’expérience.

De plus, le retard mène à une spirale infernale : dans un contexte technologique évoluant très rapidement, certains éléments doivent être réécrits en cours de projet pour suivre la concurrence, ce qui provoque de nouveaux retards. Pour un projet qui dure quatre ans, on peut estimer que le cœur technologique du programme aura dû être réécrit deux ou trois fois.

Cette augmentation des effectifs des équipes provoque également une dilution de la créativité. Alors que dans une équipe de trois personnes chacun se sent investi d’une vocation artistique évidente, il s’effectue une certaine hiérarchisation dans une équipe de quinze personnes, un peu comme dans le cinéma où l’apport artistique de celui qui tient la perche n’est pas vraiment mis en valeur.

Expansion et concentration

Au milieu des années 90, les éditeurs connurent une explosion de leurs effectifs : un jeu nécessitant environ quinze personnes, et un éditeur développant une dizaine de jeux simultanément, il est facile de faire le calcul.

Par exemple, la Société Cryo-Interactive, qu’on peut considérer comme une « suite » d’Ere Informatique, vit ses effectifs passer en une seule année (1995) de 40 à 150 employés. Cette internalisation complète de la production montra un problème nouveau pour le secteur, celui de la motivation des employés : il est difficile de convaincre chacun que son projet est LE projet de l’année lorsque autant de projets sont menés de front par des équipes différentes mais théoriquement solidaires.

Par exemple, la Société Cryo-Interactive, qu’on peut considérer comme une « suite » d’Ere Informatique, vit ses effectifs passer en une seule année (1995) de 40 à 150 employés. Cette internalisation complète de la production montra un problème nouveau pour le secteur, celui de la motivation des employés : il est difficile de convaincre chacun que son projet est LE projet de l’année lorsque autant de projets sont menés de front par des équipes différentes mais théoriquement solidaires.

Aussi la tendance actuelle est-elle à l’externalisation : un grand nombre de studios se sont créés depuis deux ou trois ans. Ces Sarl ont moins de dix employés, tous ou presque célibataires et hypermotivés, un seul projet en cours, et sont financées par un éditeur, qui, à l’extrême, ne conserve qu’un service de R&D qui assure le lien, la cohésion technique et le support des différents studios.

Au contraire on assiste à une concentration des éditeurs, qui ne laisse pas de place pour les petits : Infogrames a ainsi racheté en moins de trois ans Océan, Canal+Multimédia et Accolade.

Une révolution : la 3D en temps réel

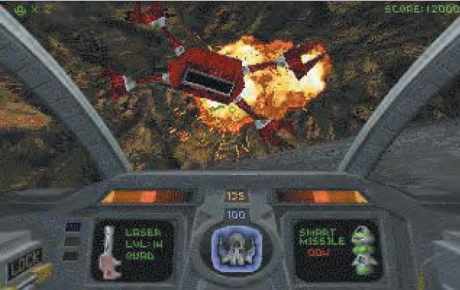

En 1992 sortit Alone in the Dark, un jeu français qui annonçait une nouvelle révolution en proposant des images en 3 dimensions calculées en temps réel. Contrairement à la 3D précalculée, la 3D temps réel consiste à calculer les images au moment même de les afficher. Ceci permet une interactivité nettement meilleure, puisque les actions du joueurs peuvent influer directement sur la position de la prise de vue de l’image. En 1992, en franchissant la barrière des 33 MHz, les micro-ordinateurs devenaient capables de calculer plusieurs de ces images par seconde.

Les calculs en jeu dans ce mécanisme sont des calculs d’algèbre linéaire plus ou moins complexe : transformation orthogonale, projection, usage des quaternions, mais aussi application des textures. Ce dernier point nécessite théoriquement deux divisions par point de l’écran, ce qui même actuellement est prohibitif. Il y eut à partir de 1993 une sorte de course à l’algorithme qui permettrait d’éviter ces deux divisions : tables de division, passage par les logarithmes pour remplacer les divisions par des soustractions…

Plusieurs techniques furent essayées avant que le jeu Descent mette, en 1995, tout le monde d’accord avec une technique malheureusement peu élégante. C’était là une nouveauté : un travail de recherche dont les résultats étaient rendus publics. À partir de cette époque, la plupart des éditeurs recrutèrent quelques jeunes spécialistes issus parfois de la recherche et ayant toujours un bagage scientifique appréciable.

Une jonction s’est ainsi effectuée entre recherche et jeu vidéo, et chaque année se tient le Siggraph, conférence internationale sur les technologies d’images de synthèse très courue dans les deux milieux.

L’arrivée d’Internet

La démocratisation d’Internet commença en 1995. Saluons au passage la perspicacité de l’École polytechnique qui sous l’influence de J.-J. Lévy, professeur d’informatique, installa le réseau des réseaux dans les chambres des élèves dès 1993. À partir de cette époque, des projets mêlant 3D et réseau naquirent en plusieurs lieux de la planète, reprenant en cela des idées apparues dès 1992 dans le livre Snowcrash de N. Stephenson. Ces projets furent tous confrontés aux mêmes difficultés.

La technologie Internet suit un rythme particulièrement lent : elle détient le triste honneur d’être la seule technologie qui a connu une régression au cours des années : entre 1993 et 1995, les débits offerts à l’utilisateur (et notamment les débits transatlantiques) furent divisés par 100 ! Ceci était certes dû à l’explosion du nombre d’utilisateurs du réseau, et le débit global a augmenté, mais pour le client final le résultat est bien une chute spectaculaire. Aujourd’hui, en 1999, un facteur d’environ 10 a été regagné, mais on est encore loin des performances dont jouissaient les élèves de l’X en 1993. Pour une industrie habituée à la loi de Moore qui multiplie par deux tous les dix-huit mois toutes les caractéristiques d’un ordinateur (fréquence processeur, mémoire, disques…), c’est une difficulté nouvelle.

Ensuite, il est quasiment impossible de tester un tel jeu : contrairement à un jeu classique, un jeu Internet (on dit un jeu on-line) permet à plusieurs joueurs de s’affronter dans un même univers. Il devient impossible de tester tous les comportements (par nature imprévisibles) d’un nombre quelconque de joueurs. De plus, il est difficile d’organiser des tests avec des centaines de joueurs connectés simultanément depuis divers points du globe. Le développement d’un tel jeu nécessite donc une étude préalable (« statique » dans le jargon informatique) qui calcule les éventuelles limitations et propose des algorithmes différents qui font disparaître ces limitations.

Un jeu on-line nécessite une infrastructure serveur, c’est-à-dire un ordinateur qui reste allumé en permanence et qui sert de point de rencontre des joueurs et joue le rôle d’arbitre et de meneur de jeu. Ceci est une nouveauté pour l’industrie du jeu vidéo : un programme qui fonctionne 24 heures sur 24, 365 jours par an ; il faut prévoir la maintenance. La nécessité de la maintenance est une remise en cause de tout le processus de développement d’un jeu.

Pour un jeu classique, il y a peu de programmeurs (deux ou trois), et celui d’entre eux qui a la tâche d’intégrer tous les éléments du logiciel joue un rôle clef : sa santé et sa disponibilité sont cruciales pour la bonne fin du projet. Lorsque le projet est terminé, il n’est pas rare de le voir partir vers d’autres aventures, et la documentation souvent sommaire qu’il laisse ne permet pas d’envisager une quelconque maintenance du produit.

Cette absence de documentation et de génie logiciel est certes regrettable mais elle est une constante dans ce secteur, et elle permet d’abaisser les coûts de production, sur le court terme seulement. D’aucuns diraient qu’elle stimule l’esprit créatif. Pour le jeu on-line, la maintenance est une exigence car un produit on-line n’a pas de fin, et de même que la 3D temps réel avait permis au jeu vidéo de se rapprocher de la recherche, la technologie on-line lui permet de se rapprocher des SSII.

Ces nouvelles difficultés sont telles que les premiers jeux on-line qui décrivaient un monde unique dans lequel les joueurs interagissent, mais qui évolue lui-même en l’absence des joueurs (on parle de monde persistant) sortirent à partir de 1997, mais souvent avec une bonne année de retard, et peu de leurs auteurs sont vraiment fiers de ce premier essai.

Au-delà des difficultés techniques le jeu on-line offre une problématique en termes de contenu que Philippe Ulrich appelle « l’interactivité de masse ». De quoi s’agit-il ? L’interactivité à deux est assez simple : c’est un jeu de combat. À quatre, c’est la belote. À vingt-deux c’est le football, mais tous les joueurs ne jouent pas le ballon en même temps. À mille, c’est le concert. À dix millions, c’est la télévision.

Bibliographie

-

Bâtisseurs de rêves par Daniel Ichbiah.

First documents (existe aussi en Poche). - Hackers – heroes of the computer revolution par Steven Levy. Delta.

-

Le samouraï virtuel (Snowcrash) par

Neal Stephenson. Robert Laffont. - Pilgrim in the microworld par David Sudnow. Warner Books.

Au fur et à mesure que le nombre de participants croît, l’interactivité diminue. Comment maintenir la motivation du joueur dans ces circonstances ? Assurément les concepts de jeu « à l’américaine » où chaque joueur doit sauver le monde du chaos et de la destruction ont vécu pour le on-line. De nouveaux projets sont en cours, qui tenteront de tourner cette difficulté.

Après des débuts difficiles, car il est souvent marginalisé et peu reconnu, le jeu vidéo entre donc dans une phase de maturité. Pour autant le dynamisme est toujours présent, et l’imagination reste une valeur sûre. C’est sans doute là que réside le mystère : d’où vient cette fascination pour l’écran que l’on constate déjà chez les tout-petits ? quelle est cette pulsion créatrice qui nous pousse à représenter sur un écran ce que nous ne pourrons jamais toucher ? pourquoi est-il jubilatoire de manipuler de vains effets de bord ?